在人工智能大模型快速发展的今天,如何在保护用户隐私的同时高效运行 Transformer 模型,已成为学术界与产业界共同关注的前沿问题。用户的输入数据往往涉及医疗、金融、语音等高度敏感的内容,而大模型的参数本身则是企业的核心资产。如何做到“既能用,又安全”,是隐私计算研究必须解决的关键挑战。然而,现有的隐私推理框架往往依赖同态加密(HE)处理线性层、依赖多方安全计算(MPC)处理非线性层,不可避免地引入频繁的协议切换与通信,导致开销居高不下。以往的工作虽然尝试在层与层之间进行有限的融合,但受制于密文比特宽度膨胀和运算协议效率不足,其提升效果仍相对有限。

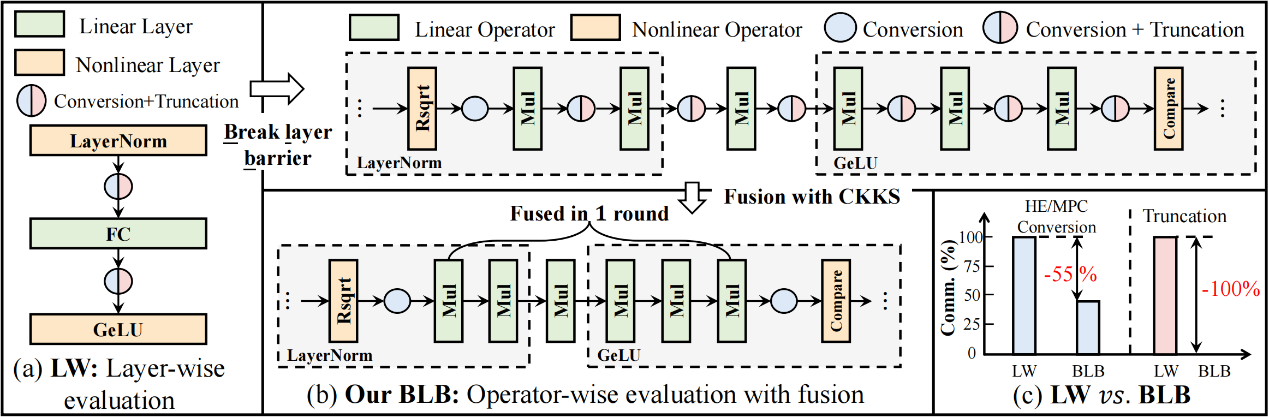

在此背景下,北京大学集成电路学院李萌助理教授团队与 TikTok 的联合团队提出了一种全新的隐私推理框架 BLB(Breaking the Layer Barrier)。BLB 的核心思想是“打破层级边界”,不再将一层作为基本单位,而是将模型拆解到算子级别进行细粒度融合。在 Transformer 模型中,诸如 LayerNorm、GeLU、Softmax 等非线性层都可以分解为多个线性算子与非线性算子的组合。BLB 通过将这些算子重新组合与融合,最大限度地减少了 HE 与 MPC 之间的切换,从根本上降低了通信开销。团队还首次提出了真正安全的 CKKS ↔ MPC 转换协议,解决了以往方案存在的隐私泄露隐患,并利用 CKKS 的 rescale 特性控制了密文比特宽度的增长。在大规模矩阵乘法这一核心操作上,BLB 设计了旋转优化的同态协议,并结合 Multi-head Attention 的批处理特性与 BSGS 优化,实现了对现有方法 8~29 倍的计算加速。

图 1 BLB框架高层次示意图

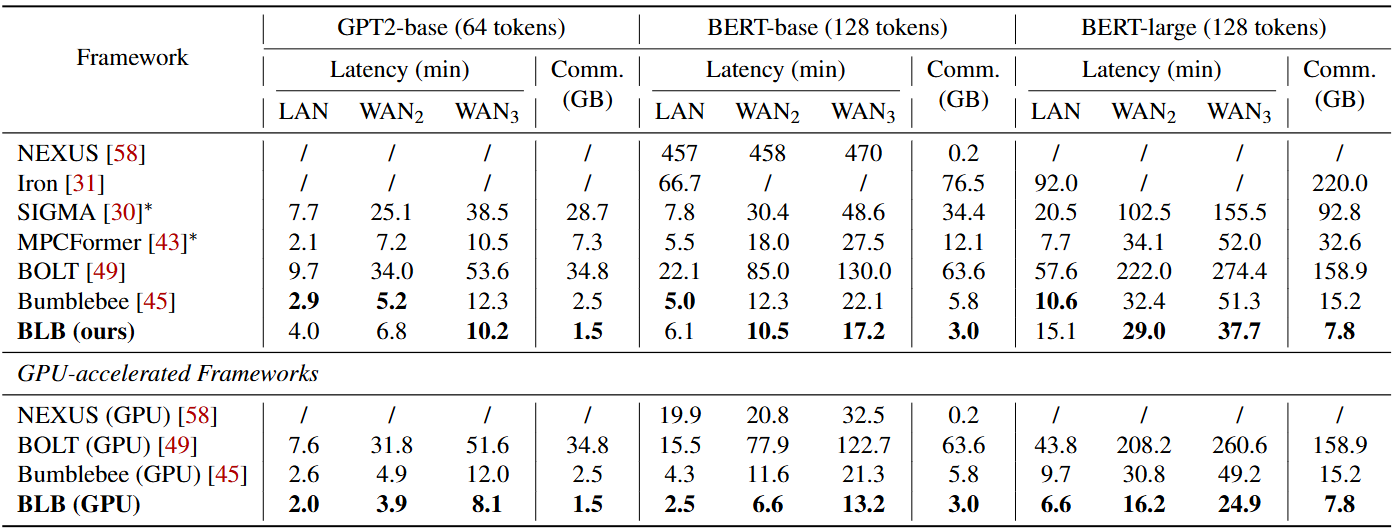

实验结果表明,在 BERT与 GPT2等Transformer-based模型上,BLB 相比 BOLT (S&P’24) 将通信量降低 21 倍,相比 Bumblebee (NDSS’25) 降低 2 倍;在 GPU 加速下,推理延迟最多可降低 13 倍。正如审稿人所评价的那样,BLB 的思想不仅适用于 Transformer,更能够推广到广泛的双方隐私计算任务场景,为未来大模型的隐私保护推理提供了全新的路径。

表 1 BLB与其余SOTA框架性能对比

该研究以北京大学李萌助理教授为通讯作者,北京大学集成电路学院博士生许天识、俞江瑞与TikTok研究员陆文杰共同担任一作。成果已在 USENIX Security 2025 正式发表,展现了产学研结合在隐私计算与人工智能交叉领域的巨大潜力。

USENIX Security Symposium 是全球计算机安全领域最具影响力的顶级学术会议之一,同时也是 CCF A 类会议,与 IEEE S&P、ACM CCS、NDSS 并称为“安全四大顶会”。会议自 1990 年创办以来,持续推动了密码学、系统安全、隐私保护、网络防御等方向的发展。凭借严格的评审机制与约 17% 的低录用率,在该会议上发表论文被广泛视为安全与隐私研究领域的重要突破与最高荣誉之一。