北京大学集成电路学院孙广宇团队在面向边缘侧大语言模型(LLM)推理加速的DRAM近存计算架构方向取得重要突破。该团队基于混合键合工艺,研发了H2-LLM架构,有效解决了传统DRAM近存计算架构在边缘设备上算力受限的问题。H2-LLM提出了通用近存计算架构模板和"以数据为中心"的数据流抽象,并开发了设计空间探索框架,相比基线架构实现了2.72倍性能提升和1.48倍能效提升。

LLM已成为人工智能领域最具影响力的技术突破之一。凭借强大的语言理解与生成能力,LLM在问题推理、聊天助手、代码补全等多种任务中展现了出色性能。随着大语言模型的广泛应用,如何在边缘设备上实现高效的大语言模型推理,在满足用户的个性化定制、数据隐私等需求的同时,提供流畅的用户体验,已成为大语言模型落地部署中亟待解决的重要问题。

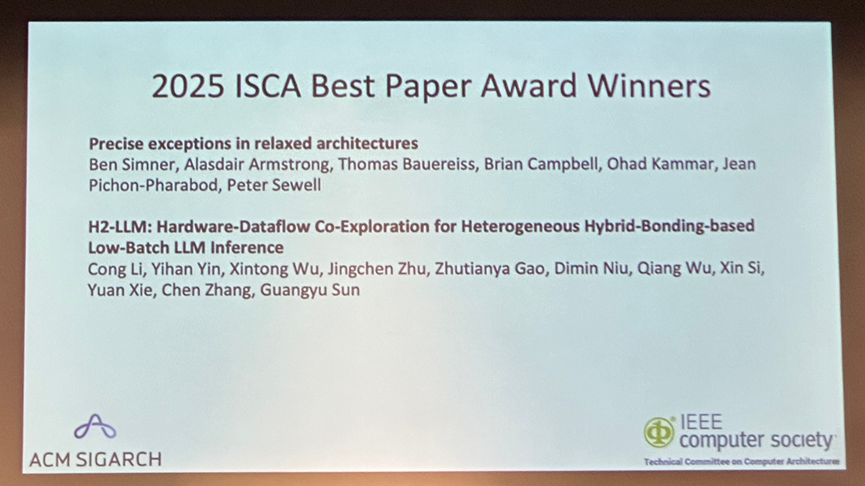

这项研究是北京大学与上海交通大学、东南大学、后摩智能及阿里巴巴达摩院共同完成的产学研合作成果,发表在第52届计算机体系结构国际研讨会(ISCA)上,并获得最佳论文奖,这是国内学术机构首次在ISCA获此殊荣。

孙广宇团队长期专注于领域定制芯片架构设计与自动化研究,已在体系结构四大会发表28篇论文,并获得多项最佳论文奖。该团队的研究成果已应用于多款芯片设计,并在国内知名企业得到验证,为解决国家在人工智能芯片领域的"卡脖子"问题做出了贡献。