人工智能(AI)需要强大的计算能力和海量的数据。这些计算可以由CPU、GPU或专用加速器完成,虽然数据在传输到处理器的过程中会通过DRAM,但最适合这一用途的DRAM类型取决于执行训练或推理任务的系统类型。

当前工程团队面临的内存挑战是如何跟上AI快速增长的计算需求,而同步动态随机存取存储器(SDRAM)在这里起着关键作用。所有这些数据都需要被处理、存储和访问,任何环节的不匹配都可能影响系统的整体性能。

“我们拥有如此强大的计算能力,”Cadence产品营销集团总监Frank Ferro表示,“但从内存带宽的角度来看,该如何充分利用它呢?”

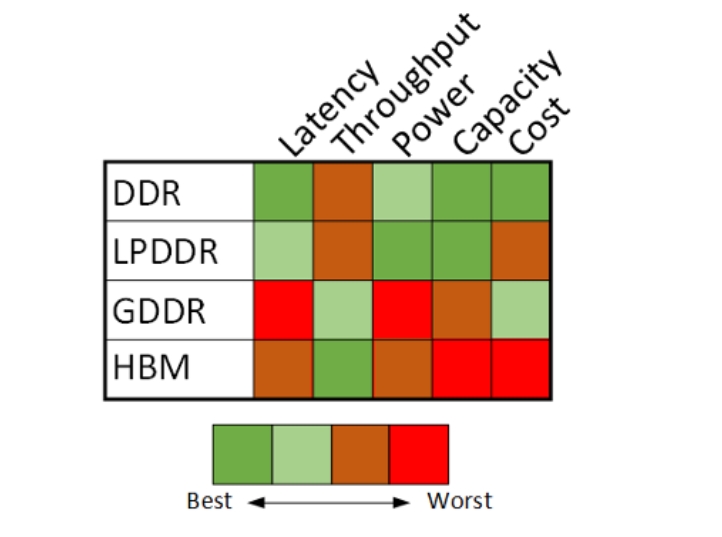

这个问题并没有简单答案,也不存在一刀切的解决方案。目前,市场上有四种同步DRAM(SDRAM)类型,每种都有针对性用途和各自的优缺点:

双倍数据速率(DDR)内存通常与CPU(尤其是复杂指令集架构处理器,即CISC处理器)配合使用。程序可能包含复杂的分支和多种操作,DDR正是针对此类计算优化的。DDR是最通用的架构,具有最低的延迟(首个数据的到达时间),且带宽适中(使用64位数据总线)。

“双倍数据速率”这一名称源自于数据可以在时钟信号的上升沿和下降沿进行存取,而传统内存和逻辑电路通常只在单边沿进行操作。

低功耗DDR(LPDDR)与DDR类似,但为了在保持高性能的同时降低功耗,各代产品中引入了许多节能特性,包括:更低的供电电压;温度补偿刷新率,低温环境下减少刷新频率;深度和部分掉电模式;部分阵列刷新选项;写入均衡,补偿数据选通信号和时钟信号之间的偏差;命令/地址训练以优化信号时序和完整性;更低的I/O电容;在后几代产品中使用6位单数据速率(SDR)命令和地址总线,而非早先的10位DDR总线;两个半宽总线而非一个全宽总线;差分时钟;数据复制和Write-X(全写1或全写0)命令,减少特定用例的数据传输量;动态电压频率调整(DVFS)。

在后几代产品中,时钟结构更加复杂,保持持续运行的主时钟频率为四分之一速度,由此衍生出多个仅在需要时运行的全速时钟。LPDDR不会安装在双列直插内存模块(DIMM)中,而是采用BGA封装,直接焊接到主板上。

图形DDR(GDDR)是为配合GPU进行图形处理而开发的变体。它具有比DDR高得多的带宽,可以向处理器传输大量图形数据,但也具有比DDR更高的延迟。“GDDR更适合高带宽应用,但容量是个问题,”Ferro说。

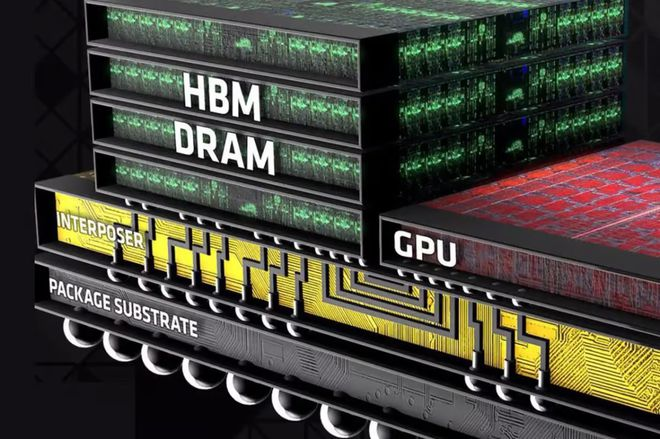

高带宽内存(HBM)由堆叠的DRAM芯片组成,具有超宽总线,适用于对带宽要求极高的计算任务,如AI训练、推理和高性能计算(HPC)。

Ferro指出这四种DRAM类型的主要区别在于访问协议,而非存储单元本身。“无论您使用GDDR、LPDDR、DDR还是HBM,其底层基本采用的是相同的内存技术,关键是如何访问DRAM。”

这些不同的访问方式可能对性能和功耗产生重大影响。

数据中心之王:HBM

HBM在数据中心领域占据着不可撼动的统治地位。“我们认为HBM仍将主要应用于数据中心的训练任务和超高速接口领域,”Expedera首席软件工程师Ramteja Tadishetti表示,“但其高昂的价格注定使其局限于高端市场,难以进入注重成本的边缘设备。”

尽管HBM能耗与价格均属最高,但数据中心的其它零部件也一样。Quadric首席营销官Steve Roddy指出:“与训练芯片采用的整片光罩尺寸晶圆相比,HBM的成本和功耗不过是零头。这就像房地产——如果你斥资2500万美元在比佛利山庄购地,绝不会在房屋建造上省预算。数据中心同理:既然已投入巨资用于芯片和封装,HBM的增量成本微不足道。我们还未发现HBM在数据中心之外的任何应用规划,就连高端汽车市场也没有。开发L4级自动驾驶系统(ADAS)的车企需要风冷散热且单价低于四位数的芯片方案,根本无法承受功耗达千瓦级、成本超1万美元的模块。”

这种成本壁垒迫使预算有限的厂商作出妥协。“超大规模服务商通常资金雄厚,可以直采HBM,”新思科技内存接口产品线总监Brett Murdock解释道,“而二线厂商必须进行权衡,因其采购量往往难以引起HBM供应商或2.5D封装厂商的重视,从而无法获得支持。”

训练任务对带宽的需求远高于推理,这使得HBM在该领域尤为重要。虽然数据中心推理仍会采用HBM,但LPDDR和GDDR正逐步渗透。“HBM因支持近内存计算(NMC)而在模型训练中风靡,”Ferro分析道,“我推测GDDR和LPDDR将成为推理加速器卡上的主流内存。”

Murdock对此表示认同,并指出混合方案的趋势:“训练比推理需要更多内存,因此可以考虑HBM4与LPDDR6组合,其中LPDDR6仅用于扩容——除非你已因其他原因放弃HBM4转用LPDDR6。”

三星也观察到类似动向。“混合内存方案正日益普及,”三星IP与生态系统营销高级总监Kevin Yee透露,“不再局限于单一选择,为优化功耗,现可见DDR与LPDDR混搭,或HBM与LPDDR组合。”

定制化HBM正成为新方向。大批量采购商可与内存制造商合作,将堆栈底层的标准逻辑芯片替换为具有专有增值功能或优化通道的定制芯片。“采用私有Die-to-Die协议的定制HBM能提供更优带宽与能效,”Yee强调。

散热问题对于堆叠结构的HBM尤为关键。Fraunhofer IIS自适应系统工程部设计方法学负责人Roland Jancke指出:“构建3D堆栈模型存在诸多散热挑战,无论纯内存堆叠还是包含处理器、传感器、存储器或其它组件的混合堆叠皆然。”

最后,还有地缘政治的变量。“除供应与成本外,政治因素也不容忽视,”Murdock直言,“粗略来说,HBM对中国企业基本禁运。因此中国公司当前AI设计采用LPDDR5X,并正向LPDDR6过渡。”

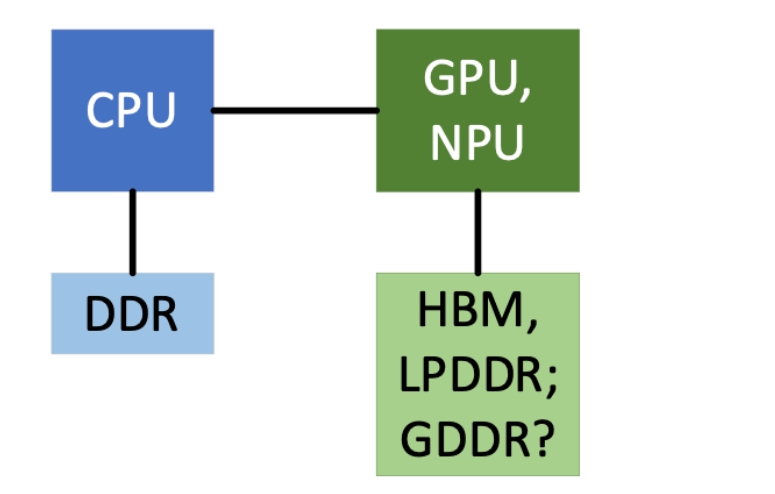

CPU的最佳搭档:DDR

DDR在数据中心虽有一席之地,但通常仅服务于协调运算的CPU。无论是GPU还是神经网络处理器(NPU),加速器在数据中心往往依赖HBM实现高带宽,或选择LPDDR追求低功耗。

“服务器与DDR向来密不可分,”Murdock指出,“如今DDR5 RDIMM仍是黄金标准,但部分厂商正转向DDR5 MRDIMM(多路复用RDIMM),该技术能以现有DRAM提升性能。不过DDR5 MRDIMM在价格与功耗方面均高于常规产品。”

但DDR对AI数据模式的优化有限。“DDR仍是可靠的二级存储方案,”Expedera的Tadishetti表示,“但除非在延迟和性能上有显著改善,否则其能效比不及LPDDR,性能指标也难以匹敌GDDR/HBM。”

即便如此,DDR的普及度和低价优势无可替代。“对于不受功耗限制的大规模推理优化设备,DDR仍是首选本地内存,”Roddy分析道,“任何线路供电(家庭/办公室/工厂)或自带供电系统(汽车)的设备中,DDR在速度与成本的综合表现上始终处于不败之地。运行在NPU子系统的推理应用通过智能管理外部内存,可对DDR访问进行批量预取,在利用DDR规模化成本优势的同时最大化性能。”

新晋宠儿:LPDDR

LPDDR正逐步渗透各类系统,即便无法完全替代其他方案,也能通过混合配置降低功耗。

“对电池供电或功耗受限设备,LPDDR在带宽与功耗的平衡上更胜一筹,”Roddy强调,“手机市场催生的海量LPDDR需求,使其成为多数新兴AI消费电子和便携设备的成本敏感型选择。”

这一观点获得了广泛认同。“LPDDR是内存领域的万能者——甚至在某些场景堪称大师,”Murdock补充,“它同时统治着移动和汽车应用市场。”Rambus内存接口芯片产品营销副总裁John Eble透露:“甚至可通过堆叠LPDDR来扩容。”

LPDDR也以一种降低功耗的方式进军数据中心,尽管它仍无法满足超大规模服务商的全部需求。“LPDDR主要缺陷是缺乏RAS(可靠性/可用性/可维护性)功能,且ECC纠错能力不足,”Eble指出,“例如缺少应对DRAM芯片失效的恢复机制,其设计初衷本就不考虑此类高阶RAS能力。”

值得注意的是,即便在CPU传统势力范围,LPDDR也已打开突破口。“英伟达推出的Grace Arm处理器就选择了LPDDR内存,”Eble补充道。

在性能至关重要的边缘系统中,LPDDR也可能取代DDR。“多数边缘设备本就不配备内存,即便配备也需求极低,因此通常选择最廉价方案,”Murdock解释,“而那些真正需要内存性能的设备,则会因LPDDR的能效特性选择它。”

GDDR,AI永远的陪衬?

在AI系统中,GDDR(图形双倍数据速率内存)的身影相对罕见。尽管其特性本应吸引AI应用,但它在关键参数上总略显平庸:吞吐量高于LPDDR却不及HBM,成本低于HBM或LPDDR却又不如DDR便宜。没有一项突出优势能使其成为特定系统的必选项,因此在AI领域常被冷落。

“GDDR对AI应用而言就像反例的‘金发姑娘’”,Roddy形象地比喻,“总是不上不下——它对于消费级推理设备来说价格太高,而设计精良的NPU通过离线编译已能智能预取权重和激活值,根本无需GDDR的快速随机访问性能;在数据中心,HBM的绝对速度优势更是彻底取代了GDDR。”

不过,GDDR在图形相关生成算法中仍具潜力,只要容量限制不成障碍。“它主要用于图形和生成式AI的某些环节,”Tadishetti表示,“随着图像/视频生成模型的兴起,部分需求可能会转向GDDR。但需明确是,目前尚未观察到OEM厂商实际采用。”

四大技术路线

虽所有DRAM标准均源自JEDEC,但每类内存由不同委员会主导:DDR归JC-42.3小组(标准命名惯例中JC-42涵盖所有固态存储器),GDDR由JC-42.1标准化,HBM隶属JC-42.2,LPDDR则由JC-42.6负责。这四类DRAM仍在同步演进,但LPDDR与HBM显然更受瞩目。

Murdock指出:“LPDDR5X已实现高可用性和合理价位,能满足多数应用的能效需求。由于性能提升显著,设计阶段对LPDDR6的需求已开始显现。”

尽管LPDDR6的具体改进尚未公开,但预计将重点优化时钟频率、存储方式、总线宽度和突发访问。此外还将内置纠错码(ECC),以应对高速运行下的信号完整性挑战,预计年底前量产上市。

HBM4则是下一代高带宽内存的焦点,其带宽、通道数和数据总线宽度均较HBM3翻倍,预计2026年上市。“当前主流仍是HBM3E,但随着HBM4标准的发布,设计将快速转向性能更强的HBM4,”Murdock补充道。

持续演进格局

即使内存速度不断提升、功耗降低,处理器也在同步进化。理想状态下,处理器与内存应当协同演进,避免任何一方成为性能瓶颈。但由于二者独立发展,技术迭代中难免出现交替领跑的局面。

尽管专用NPU难以实现大规模普及,但部分低功耗方案已展现出潜力。若这类方案获得市场认可,势必将对功耗敏感型系统中的内存提出更严苛的要求。同样,随着数据中心处理器性能不断突破,HBM也必须保持同步升级。

仅仅选对内存类型并不足够——确保高质量的信号访问对高速运行至关重要。“从系统性能角度来看,通道设计才是最关键的因素,我们必须重视信号完整性,”Cadence的Ferro强调,“作为系统设计师,理当能随意更换不同厂商的GDDR6内存芯片。但实际可能遇到:某款GDDR6运行速度为16GB/s,而另一款却有18GB/s版本。虽然直接替换也能工作,但原有通道真能承载18GB/s的速率吗?”

尽管行业趋势已逐渐明朗,系统设计师仍需深入评估,既要为特定系统选择最适配的内存方案,更要确保整个系统具备匹配的处理能力。

参考来源:https://semiengineering.com/the-best-drams-for-ai/

(校对/孙乐)