6月18日,GSMA 2025 MWC上海正式拉开帷幕。在大会首日举办的“代理式人工智能峰会”上,高通技术公司AI/生成式AI产品管理副总裁Vinesh Sukumar博士发表主题演讲,分享了对于AI发展新趋势的看法。

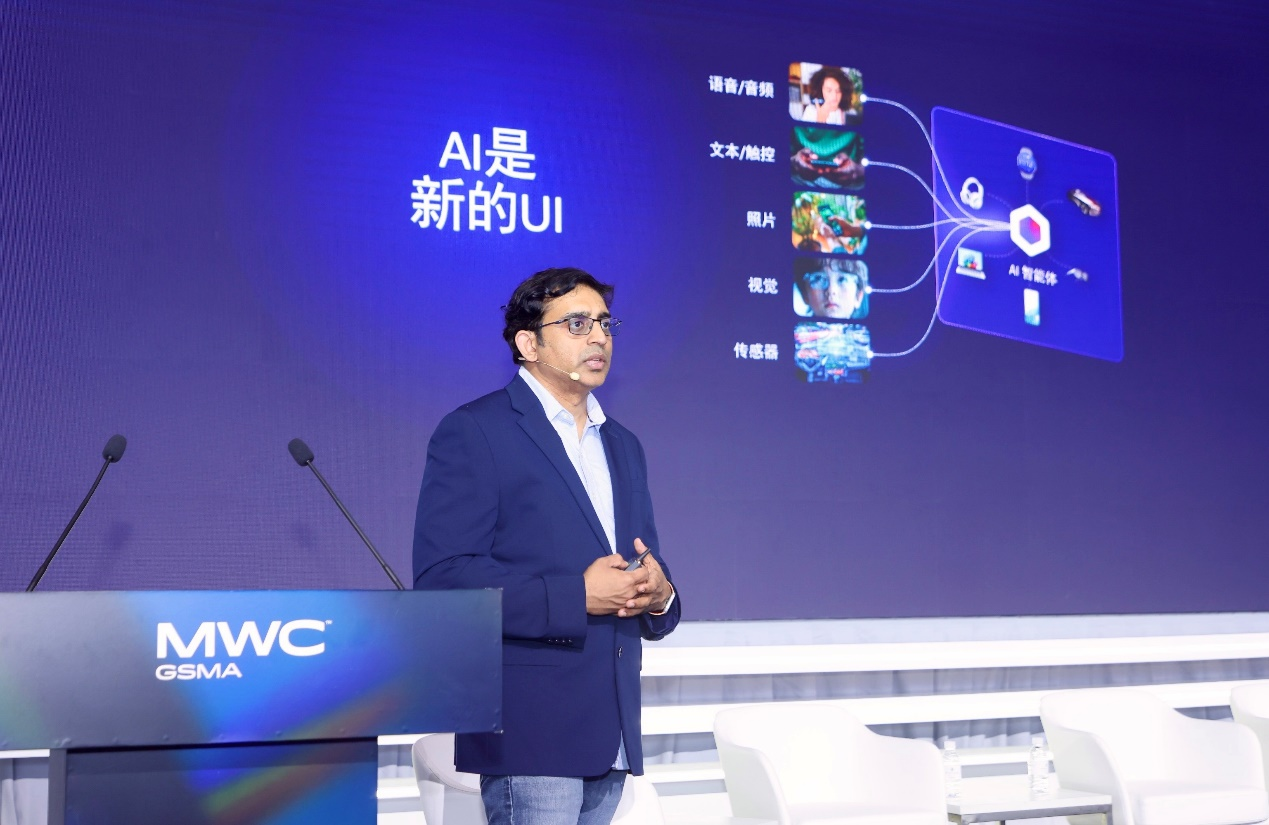

Vinesh Sukumar博士指出,AI发展正在进入全新阶段,AI发展重心正在向边缘终端转移。当前,AI正在向智能体AI领域转型,高通相信AI将成为新的UI,并覆盖广泛终端。与此同时,为实现这一愿景,高通公司已经构建了覆盖广泛边缘终端的硬件和软件技术,为智能体AI体验在终端侧的发展打造了坚实基础。

纵观AI的发展历程,早期AI技术主要集中在分割、检测、分类、图像增强等感知AI领域,为赋能智能手机体验奠定了基础。但随着时间的推移,上述体验也在快速进行演变,类似技术扩展到了汽车、PC等市场,以及XR和工业网络等新兴领域。

在这些领域中,行业探讨的重点从感知数据到多模态数据的转变,多模态数据可以是文本、图像或视频形式,且全部都基于提示(prompt)生成。将这些技术匹配到不同的应用赛道上,从而帮助在生产力、游戏甚至内容生成领域打造全新的用户体验。而高通正在将这些知识积累应用到所有相关领域。

Vinesh Sukumar博士强调,高通非常重视生成式AI和智能体AI,是最早展示大模型可以完全在边缘运行的芯片平台厂商之一。

对于AI未来的发展方向,Vinesh Sukumar博士表示,高通非常重视与众多的模型开发者合作,致力于推动大型基础模型向更加垂直行业或任务专用型模型转变,并助力实现边缘终端运行。这些行业专用模型可能会非常庞大,参数量可能达到70-100亿,高通已经开始推动这些模型在不同形态的终端上运行。

“在模型领域,过去人们通常认为更大的模型意味着更好的质量,但纵观大模型的发展过程,从通义千问、Meta、Google或微软推出的模型中可以看出,小模型的质量正在快速提升并追赶大模型的能力。以模型智能指数对比为例,众多的小语言模型(SLM)已经达到了Llama 3 700亿参数大模型的水平。”Vinesh Sukumar博士说。

为何边缘模型正在变得愈发重要和关键?Vinesh Sukumar博士指出,这是因为它们能够在生产力或内容创作领域为用户提供丰富的体验。过去,模型会面临如何真正实现终端侧部署的挑战。针对这一挑战,高通提供了高通AI软件栈,能够支持模型完全在边缘平台部署。高通始终致力于为包括开发者在内的生态系统合作伙伴提供机会,让应用能够实现云端训练,并在高通平台赋能的终端上运行。

在过去的12到18个月里,高通在边缘AI领域实现了诸多关键用例的商业化应用,每年赋能大约200到300个AI应用。在过去的12个月里,高通更加重视生成式AI领域。在消费领域,边缘AI已经能够支持内容创作、照片编辑、图像修复、图像扩展等诸多应用;在企业领域,包括代码生成等更多应用。

“在过去,生成式AI已经带来了诸多助力,但其仅支持单一模态。现在,我们正在向所谓的智能体AI领域转型。我们相信,AI将成为新的UI(用户界面),并覆盖广泛终端。”Vinesh Sukumar博士表示。

那么,如何实现这一目标?Vinesh Sukumar博士指出,首先取决于期望打造什么样的用户体验。为此,高通致力于融合多种数据模态。这些数据模态可能基于图像、音频、文本、语音甚至视频。基于这些模态支持,可以理解用户意图,并匹配连接多个应用以调用AI处理能力,从而满足用户需求。这催生了AI智能体概念。智能体AI侧重于解读需求并采取行动,从而走向自动化。虽然实现智能体体验颇具挑战性,但高通正在不断强化基础技术构建,为这些智能体AI用例筑牢根基。

“我们可以推动包括娱乐、电商、礼宾服务、地图导航甚至音乐等多种领域的智能体AI用例发展。为了实现这些目标,需要广泛的边缘侧布局,能够理解用户需求且将其转化为恰当操作的强大软件栈。”Vinesh Sukumar博士说。

据Vinesh Sukumar博士介绍,在将用户意图转化为恰当的操作时,总会出现某一设备可能无法回答或响应用户查询(query)的情况。这时如果用户需要进行设备间通信,可以通过高通AI软件栈来实现。高通的产品覆盖广泛的边缘终端,涵盖从手机到PC、XR等多种产品形态,因此这对高通而言来说更容易。此外,凭借在这些终端上收集到的海量用户数据,也能更成功地解读用户意图并采取行动。

Vinesh Sukumar博士还指出,智能体AI在进行商用部署时也面临许多挑战,比如智能体AI的准确性、可预测性、一致性表现,否能够精准匹配用户需求等。为此,拥有必要的软件栈支持至关重要。而高通AI软件栈非常强大,经过长期技术积累,可以支持针对特定任务的多种小语言模型。

其次,要实现更好的服务质量意味着当用户提出特定提示(prompt)时,AI能够以最快速度响应,这需要在硬件方面大力投入。为实现这一目标,高通打造了CPU、GPU等通用计算单元,以及Hexagon NPU这样的专用加速器。

最后是如何实现规模化扩展,为开发者社区提供灵活性。这一关键在于提供必要的工具和软件支持,使开发者可以更轻松适应不同的环境和情况。

“而我们已经为这些需求打造了技术基础设施。各位将在未来6个月内,看到更多来自高通的发布,将助力推出更丰富的面向消费者的应用。”Vinesh Sukumar博士说。

此外,在向AI推理时代迈进之时,会面临边缘平台因性能受限而无法解决用户查询(query)的问题。在这种情况下,如何确保用户体验不受影响?

Vinesh Sukumar博士表示,高通已经将边缘推理进行了跨多个终端的分布式部署。如果某些查询无法通过终端侧算力解决,就转而使用基于高通平台的本地边缘服务器来继续查看、理解和回答查询;如果本地边缘平台无法解决,AI会获取用户的上下文信息,然后将任务转移到中央云子系统,根据用户的个人知识图谱来处理查询,然后给出更合理的回复。