随着技术成熟度的提升和生态体系的完善,大模型的应用边界正不断拓展,从最初的文本生成、图像识别等单一任务,向跨模态理解、复杂系统控制等更高阶能力演进。这不仅要求模型足够好(准确幻觉低),同时也要求成本低,多模态,强推理,如此才能支持大规模应用上量。这必然对基础硬件提出更高要求。在近日举办的火山引擎2025 FORCE原动力大会英特尔专场分论坛上,嘉宾重点讨论了如何针对不同应用场景采取的优化策略;如何提供更优性价比的推理算力解决方案;如何实现云端算力的升级等优化芯片算力的热点话题。

打造更高性价比的智算一体机方案

当前人工智能行业的发展背景呈现出技术普惠化与产业落地加速的双重特征,以DeepSeek、Meta的Llama等为代表的开源大模型,通过公开代码、权重和训练数据,大幅降低了中小企业和开发者的技术门槛。同时轻量化的小模型也在崛起。由于大规模模型训练成本高昂,投入更小、更垂直的小模型不断涌现。例如,DeepSeek的轻量化版本在保持高性能的同时,显著降低了计算资源需求,吸引了大量中小企业的关注。大模型一体机集成了硬件算力、软件平台和预训练模型,简化了部署流程,降低了企业的技术门槛,掀起一轮市场热潮。据亿欧智库预测,中国大模型一体机市场正开启千亿级增长空间。

英特尔中国解决方案部 人工智能方案总监高丰介绍,基于Computex2025上最新推出的锐炫 Pro B60 GPU,英特尔也在积极推动智算一体机的开发。整体方案既支持 7B-72B 等主流模型,也能支持 Deepseek V3/R1 671B 本地部署,还提供了完善的主流生态软件栈和封装成服务化的EAP,可让上层应用平滑迁移到Xeon+Arc平台上,加速企业内部和边缘侧 LLM 应用落地。

锐炫Pro B60显存从16GB升级到24GB,显著增强了其在处理复杂人工智能任务与高负载专业应用场景中的性能表现,尤其在支持更强的上下文扩展和并发扩展能力方面实现了较大幅度的提升。在生成式AI任务中,显存容量直接决定了模型可处理的上下文窗口长度;在并发扩展方面,24GB显存允许同时加载多个中小型模型或单个大型模型的不同实例;在云计算场景中,显存扩容使得单张显卡可支持更多虚拟实例,降低硬件成本的同时提升服务密度,满足AI训练平台、边缘计算节点等场景的弹性需求。

除硬件之外,英特尔在软件生态方面也做了许多工作,提供了包括vLLM、PyTorch在内的完善的主流生态软件栈。这些软件栈是AI开发和应用中常用的工具和框架,能够帮助开发者更高效地进行模型开发、训练和推理。通过将这些软件栈集成到EAP中,英特尔为企业用户提供了一站式的AI开发环境,降低了技术门槛和开发成本。

高丰最后强调,对于一体机解决方案,高性价比很有必要。首先硬件平台需要具备足够高的性价比和强大的性能。其次许多企业为了追求更高的性价比,会考虑能否利用开源模型来满足足够好(Good enough)的应用场景。

至强6满足云端算力升级

英特尔中国数据中心事业部产品战略规划总监张志杰表示,数据中心需求在不断演变,不同的应用场景需要不同的优化策略。在人工智能方面,利用加速硬件和基于开放标准的软件,实现大规模出色性能;在吞吐量和时延方面,以更快的响应速度显著提升系统级性能;在大规模部署中提供更高安全性、质量和可靠性;提升机架密度,同时满足能效要求,以降低总体拥有成本 (TCO),通过优化能效和产品循环设计,减少碳排放;通过指令集架构 (ISA) 一致性,实现软件生态系统兼容性。

针对上述需求,张志杰介绍了去年发布的至强6处理器,可以满足数据中心新提出的需求和挑战。为了使至强6处理器更易使用,英特尔从架构上采用了模块化的解耦方式,将I/O die和计算die进行分离。英特尔提出能效核和性能核上对于I/O die的使用是完全可复用的,使得不仅是英特尔,包括所有的生态合作伙伴、客户,在验证过程中节省了大量资源。同时对计算die也进行了模块化处理,以满足在高核心数到低核心数整个扩展过程当中的需求。同时英特尔的产品在整个BIOS框架(Framework)上也形成了一整套体系,以适配能效核和性能核的变化。

至强6处理器从计算上可以提供高达288个物理核,在内存子系统上,相对于上一代,它的内存带宽提升了1.7倍。这主要得益于通道数从8通道提升到12通道,以及DDR5从5600到6400的提升。如果采用MRDIMM甚至可使整个带宽再提升30%,达到2.3倍的提升。至强6处理器是整个行业里第一代支持MRDIMM的平台。在大带宽的需求上,比如推广搜、AI等领域可以看到非常强烈的对于MRDIMM内存的需求。

从I/O的角度,PCIe提升了1.2倍。整个跨插槽的带宽提升了1.8倍,并将CXL 2.0应用在了至强6处理器上。在加速器方面,至强6处理器内置了4个QAT加速器,能够帮助卸载(offload)到24-32个CPU核心的计算能力。AMX作为集成在CPU内部的AI加速器,可以使CPU处理AI能力大幅提升。

在性能上,无论通用计算、Web service还是AI等领域,至强6的6900系列CPU总体提升高达2倍以上的性能,同时提高了1.4倍的性能功耗比改善。

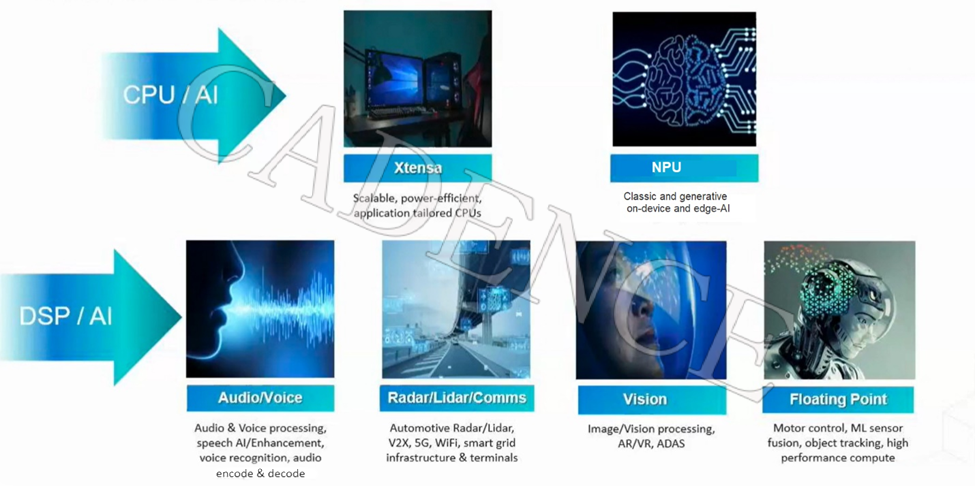

基于异构计算优化大模型推理

英特尔中国数据中心事业部 高级软件工程师缪金成指出,大语言模型的出现,为现在主要的计算设备,尤其是CPU、GPU带来了多种多样的挑战,包括GPU 计算效率低、CPU 利用率低、更高的数据移动带宽需求、GPU 显存容量限制等。大语言模型的特性分成两个阶段,分别为prefill阶段和decoding阶段,不同阶段有不同的特性。在prefill阶段主要表现为计算瓶颈;生成词的阶段则是缓存带宽出现瓶颈。在生成词的过程当中,其实常规的计算设备并不能把峰值算力完全发挥出来,因此生成词阶段计算效率并不是很高。

除此之外,部署在数据中心中的AI服务器很多CPU的利用率有限,这也是当前主要挑战之一。同时,大语言模型随着训练参数量越来越大,模型规模以及权重都需要消耗更多带宽,对数据传输带宽的要求也越高。越来越大的权重和模型相应的存储磁盘或者是存储介质的容量也要求越来越大。然而,现有的GPU显存在匹配大语言模型参数规模方面存在一定瓶颈。

为了应对上述挑战,英特尔设计了多种基于异构解决方案。针对AI服务器中CPU设备利用率不高的问题,我们观察到在stable diffusion的微调任务中,CPU的空闲的时间占总时间的97%,无法把CPU的计算能力充分发挥出来。因此,我们在这种数据的预处理或者是流水线主动去引入CPU的设备,辅助整个流水线的高效运行。

以MosaicML举例,其在训练SD2模型时,CLIP和VAE是离线预计算好的,在训练当中加载。因此SD2的训练过程可以被分为两个阶段:一是需要预计算latent的离线阶段,另外一个是离线训练的节点。现在CPU的算力已经能够覆盖一定的模型运行,尤其是预计算任务。将CPU引入到latent预计算的过程当中,可以把原来的预计算部分分为两部分,让CPU和GPU并行起来,也可以节省更多更宝贵的GPU时间,让整个训练的性价比进一步提升。经评估,采用这种异构方案优化整个数据预处理的流水线,相比传统未优化的方案,整体性价比可以提升10%。

投机执行也是针对上述挑战开发的技术之一。投机执行这项技术的灵感来自CPU的设计。其主要思路是用计算换取时间,以早期的计算过程去预测下一步的执行阶段。在大语言当中也有同样思想的投机执行的优化。业界普遍认为,由于大模型预测下一个词的计算成本较高,于是采用小模型先预测,把预测出来的词再交给大模型去验证,如果验证成功就会被采用。

最新的至强6性能核处理器具备多项新特性,能充分优化小模型。利用CPU在投机执行时运行小模型,可以更好地将GPU的处理时间和容量释放出来,进而让整个投机执行在数据中心中的部署更加高效。

针对KV Cache也有很多异构方案。KV Cache是大语言模型在生成词阶段非常重要的组件,尤其是当大规模的部署提出了Prefill 和Decode 分离的方式,将大语言模型的首词和下一个词分别部署在不同型号、不同规格的数据集群当中,能够进一步提升整体系统的吞吐能力。