1.台积电熊本二厂2025年下半年动工,将导入6nm制程

2.Crusoe计划斥资4亿美元购买AMD AI芯片,建设专用数据中心

3.日月光CEO吴田玉当选SEMI主席

4.AMD确认MI350X AI芯片将采用三星/美光HBM3E

5.AMD Instinct MI350系列GPU发布 行业最强AI性能 明年MI400更劲爆!

6.突破AI与HPC散热瓶颈:贺利氏下一代TIM1导热膏重磅发布

1.台积电熊本二厂2025年下半年动工,将导入6nm制程

台积电日本子公司总经理小野寺诚11日在横滨举行的技术论坛上表示,日本熊本二厂将于今年下半年动工,且2024年台积电在日本的营收超过40亿美元,占公司整体营收的4%。

据悉,熊本二厂原定于2025年第一季度动工,但台积电在今年4月表示,考虑到对当地交通的影响,计划将开工时间推迟至今年内。小野寺诚此次确认熊本二厂将在今年下半年开始建设。

小野寺诚透露,2024年台积电日本晶圆出货量(以12英寸晶圆换算)超过149万片,约占整体出货量的10%。

关于熊本二厂延期动工的原因,台积电董事长魏哲家曾表示,主要是因为熊本一厂量产后造成当地交通拥堵问题,引起居民不满,公司希望在交通状况改善后再开始兴建二厂。

据悉,熊本一厂已于2024年底开始量产,主要生产12至28nm成熟制程逻辑芯片。而即将动工的熊本二厂计划导入日本国内最先进的6nm制程技术。两座厂房建成后,月产能合计将达10万片以上。熊本一厂和二厂的总投资金额高达2.96万亿日元,其中台积电获得日本政府1.2万亿日元的补助。

业界预测,随着人工智能(AI)在智能手机、个人电脑及数据中心等领域广为应用,加上台积电在晶圆代工2.0 (Foundry 2.0)的市占逐步上升,台积电未来5年内,市值有望上看3万亿美元。

2.Crusoe计划斥资4亿美元购买AMD AI芯片,建设专用数据中心

Crusoe首席执行官Chase Lochmiller周四(6月12日)表示,这家人工智能数据中心建设者计划从AMD购买价值约4亿美元的人工智能芯片以增强其计算能力。

这家云计算初创公司计划在美国建立一个数据中心来容纳AMD的AI芯片,并将其出租给客户,用于构建AI模型和运行应用程序。Crusoe计划购买约13000块MI355X芯片,并使用液体冷却系统。

Chase Lochmiller在接受采访时表示,该数据中心设施将于秋季上线,可以分配给多个客户,或者,如果有客户想要使用整个集群,则可以分配给单个客户。

Crusoe的数据中心专为容纳AI芯片而建,据称这使得其性能比旧设计更卓越。该公司开发了预制组件,以加快数据中心的建设速度,就像预制房屋可以缩短施工时间一样。

AMD的AI芯片为市场中占据主导地位的英伟达硬件提供了替代方案。Crusoe计划购买的AMD MI355X芯片包含大量高带宽内存,非常适合运行AI应用程序(即推理)。

Crusoe 是众多专门为人工智能公司打造云计算服务的公司之一,这些公司通常会大量采购英伟达芯片。英伟达为这些新兴公司配备人工智能芯片,部分原因是这能让它们实现收入多元化,不再依赖微软等云计算巨头。

现在,AMD正尝试执行类似的计划。

3.日月光CEO吴田玉当选SEMI主席

国际半导体产业协会(SEMI)6月13日宣布,其国际董事会推举半导体封测公司日月光投控CEO吴田玉担任新任主席,推举康姆艾德科技(Comet AG)董事长Benjamin Loh为副主席。

日月光投控CEO吴田玉

该任命即日起生效。此前吴田玉担任SEMI董事会副主席,Benjamin Loh也是董事会成员之一。

SEMI全球总裁暨CEO Ajit Manocha表示,他们过去在担任董事会职务期间,展现了应对全球半导体产业挑战的热忱,以及推动产业加速成长的坚定承诺。随着担任新的领导职务,双方将携手合作,在全球各地为会员创造更高价值,并提升SEMI作为各国信赖伙伴的地位,持续推进半导体在科技创新中所扮演的关键角色。

SEMI全球首席营销官(CMO)暨中国台湾区总裁曹世纶表示,诚挚祝贺吴田玉与Benjamin Loh 当选新职。特别值得一提的是,日月光CEO吴田玉博士此次获选担任SEMI全球董事会主席,不仅彰显出中国台湾在全球半导体供应链中的关键地位,更是对他个人卓越领导力的肯定。

此外,吴田玉也将接任SEMI基金会董事会主席。 SEMI基金会为SEMI旗下的非营利单位,主要任务是推动SEMI全球人才发展计划。

据悉,SEMI全球董事会由18位具表决权的董事和11位荣誉董事组成,这充分展现了SEMI运营的全球化广度。董事会成员由SEMI全体会员投票选出,每位董事每届任期为3年,最多可连任5届。

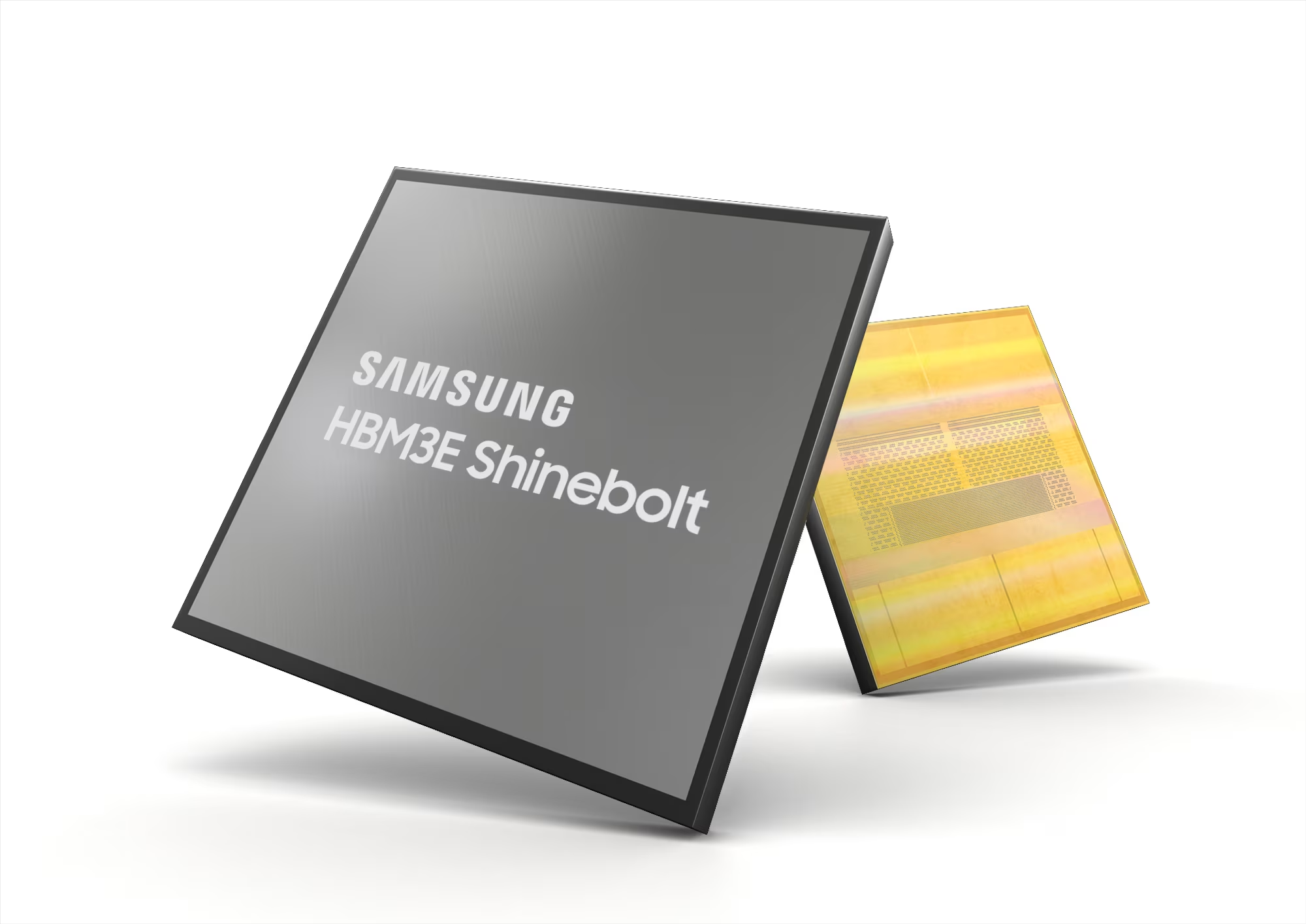

4.AMD确认MI350X AI芯片将采用三星/美光HBM3E

AMD的新款人工智能(AI)加速器MI350系列将搭载三星电子12层HBM3E芯片。这对于三星电子来说是一个好消息,因为三星电子在英伟达的HBM认证方面一直遭遇拖延。此外,人们对AMD将于明年推出的下一代MI400系列HBM4的供应也寄予厚望。

6月12日,在圣何塞会议中心举行的AI Advancing 2025大会上,AMD宣布其新款AI加速器MI350X和MI355X将搭载三星和美光的12层HBM3E芯片。虽然此前三星电子一直在向AMD供应HBM,但这是AMD首次正式确认。

MI350X和MI355X本质上是相同的芯片,仅在散热设计上有所不同,这会影响它们的最大运行速度。两款产品都将配备288GB的内存容量。上一代MI300X为192GB,而MI325X为256GB。这意味着内存容量比上一代提升12.5%。

此外,在捆绑8个图形处理单元(GPU)的平台级别,将应用总计2.3TB的HBM3E显存。AMD还宣布了一项战略,旨在提高捆绑多达128个GPU的服务器机架的销量。预计这将需要三星HBM进行大规模供应。

HBM4市场也有望于明年全面开放。AMD表示,将于明年推出的MI400系列将为每个GPU配备432GB的HBM4显存。Helios服务器机架配置72个MI400系列GPU,每个机架将集成31TB的HBM4显存,其AI计算能力是当前一代MI355X服务器机架的10倍。AMD CEO苏姿丰强调:“它的计算能力与英伟达的Vera Rubin服务器机架相当,但HBM的容量和带宽是后者的1.5倍。”

随着JEDEC规范的最终确定,HBM4正进入全面生产阶段。三星电子和SK海力士计划在2025年底前开始量产HBM4。尤其值得一提的是,三星电子在当前一代HBM竞争中落后,决心凭借HBM4扭转乾坤。SK海力士和美光正在基于第五代10nm级(1b)工艺开发HBM4,而三星电子则瞄准基于更先进的第六代10nm级(1c)工艺的高性能,力图重夺内存市场领导者地位。据市场调研公司Omdia数据,今年第一季度,SK海力士占据全球DRAM市场的36.9%,三星电子紧随其后,市场份额为34.4%,美光则为25%。

业内人士评论道:“如果三星电子无法凭借基本规格正在发生变化的HBM4东山再起,三星电子与SK海力士之间的差距只会进一步扩大。AMD也在试图通过其全新设计的MI400系列缩小与英伟达的差距,三星电子必须巩固与MI350系列建立的合作伙伴关系。”

5.AMD Instinct MI350系列GPU发布 行业最强AI性能 明年MI400更劲爆!

集微网报道 北京时间6月12日凌晨,AMD在美国圣何塞举办的“AI Advancing 2025”大会上,重磅发布Instinct MI350系列GPU新品,凭借强大的AI训练和推理能力,成为面向AI和高性能计算领域,业界最高性能的GPU产品。

与此同时,AMD还剧透了一系列即将于明年发布的产品,其中包括计算性能提升10倍,被行业视为“Game Changer”的MI400系列GPU,以及为AI而优化,并集成新一代的Instinct GPU MI400系列、第六代EPYC CPU以及新一代的Pensando Vulcano网卡的“Helios”机柜解决方案。

得益于核心业务的强劲表现以及数据中心和人工智能领域的扩张。5月,AMD刚刚发布了强劲的季报,营收74亿美元,同比增长36%,营收连续四个季度同比增长。其中受到EPYC CPU和Instinct GPU销售增长推动,一季度AMD数据中心业务收入37亿美元,同比大涨57%,数据中心AI收入同比增长两位数。

凭借强大的创新能力以及坚定的路线图执行力,AMD正努力把握AI时代的机遇,加速前行。

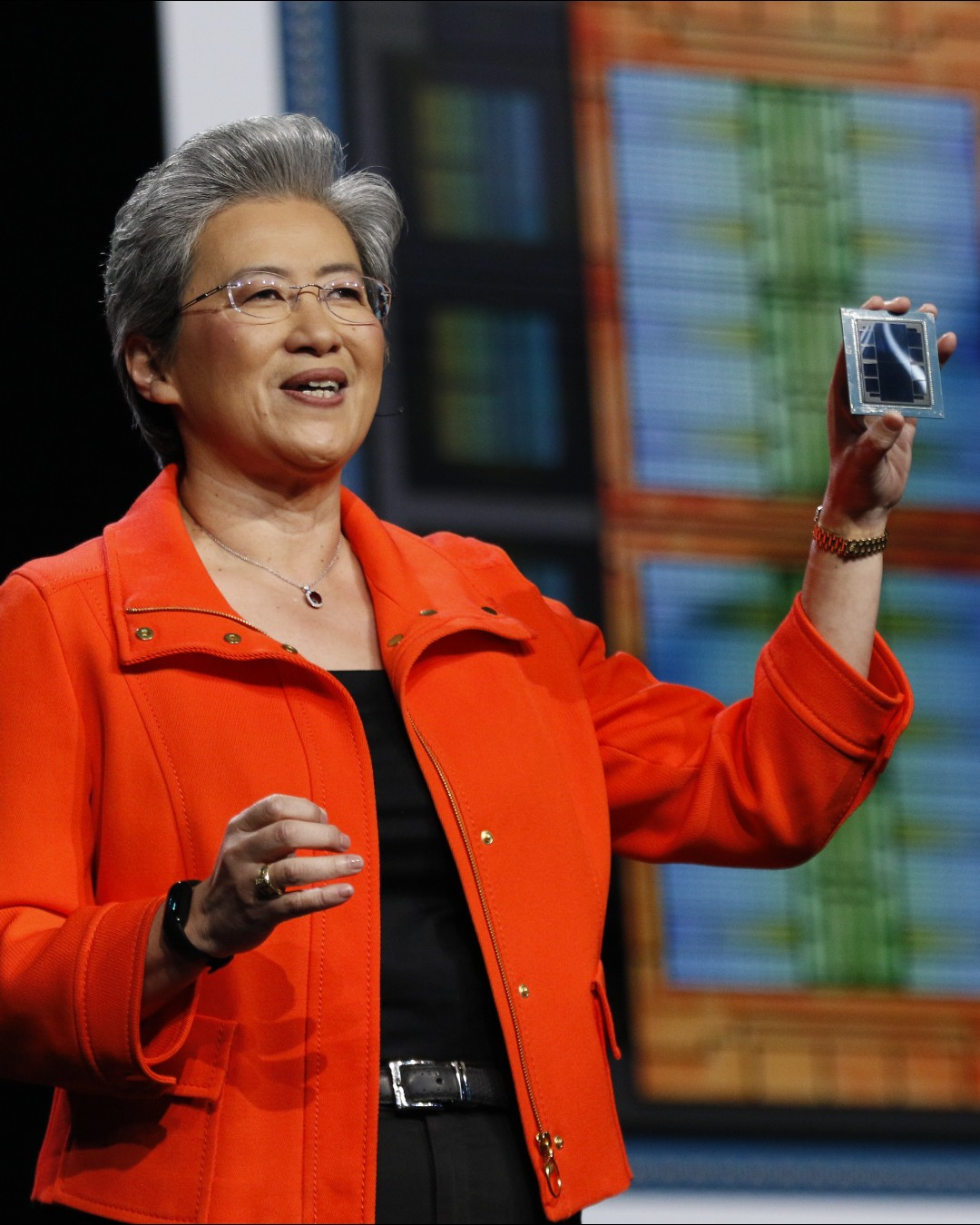

“人工智能的未来不会由任何一家公司创造,也不会存在封闭的生态中,它将由开放合作塑造。”AMD董事会主席兼首席执行官苏姿丰(Lisa Su)博士强调。

三方面战略聚焦AI 推理市场复合增速超80%

近年来,AI的快速发展远超所有人的预期。苏姿丰博士坦言她的职业生涯中,还没有哪一项技术能够像AI一样具有如此快速的创新步伐。

苏姿丰博士表示,当前随着大模型在各个领域加速部署,AI已经进入下一阶段。训练是模型开发的基础,而真正带来改变的是对推理需求的显著增加。展望未来几年,数十万甚至数百万的模型将会出现,而针对特定任务以及行业的模型将加速部署。

苏姿丰博士指出,在AI加速的背景下,AMD预计从2023年到2028年,数据中心市场规模将达到5000亿美元,年复合增速超过60%,其中推理将成为最大的驱动力量,年复合增速超过80%。

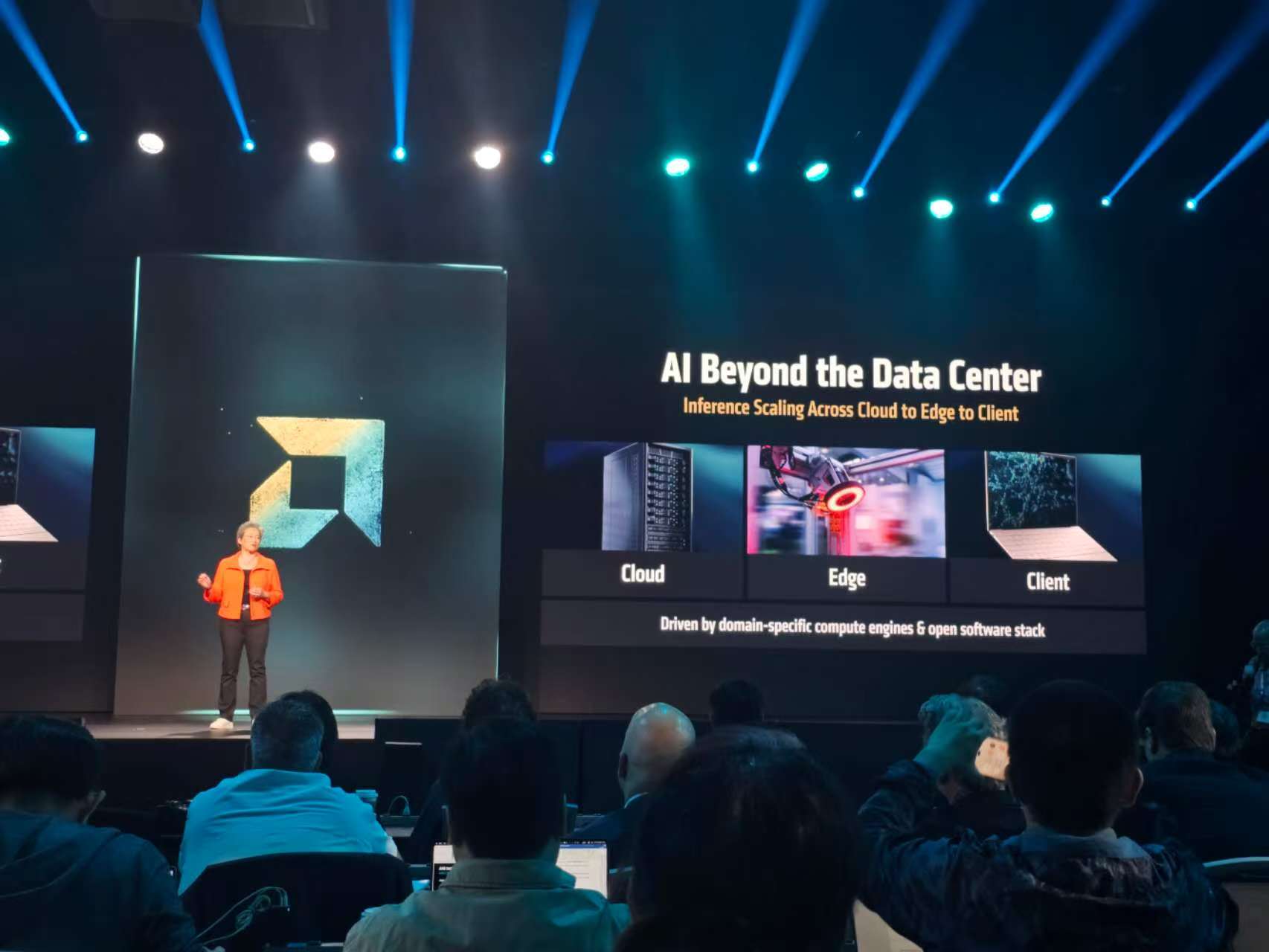

另一个趋势是,AI正在超越数据中心范畴,从边缘向更广泛的终端延伸,因此没有一种架构能够通吃所有的负载类型,而是要针对场景和负载选择合适的计算架构。

苏姿丰博士介绍,AMD的AI战略聚焦在三方面。一是打造领先的计算引擎,将正确的模型、场景和计算引擎相匹配。

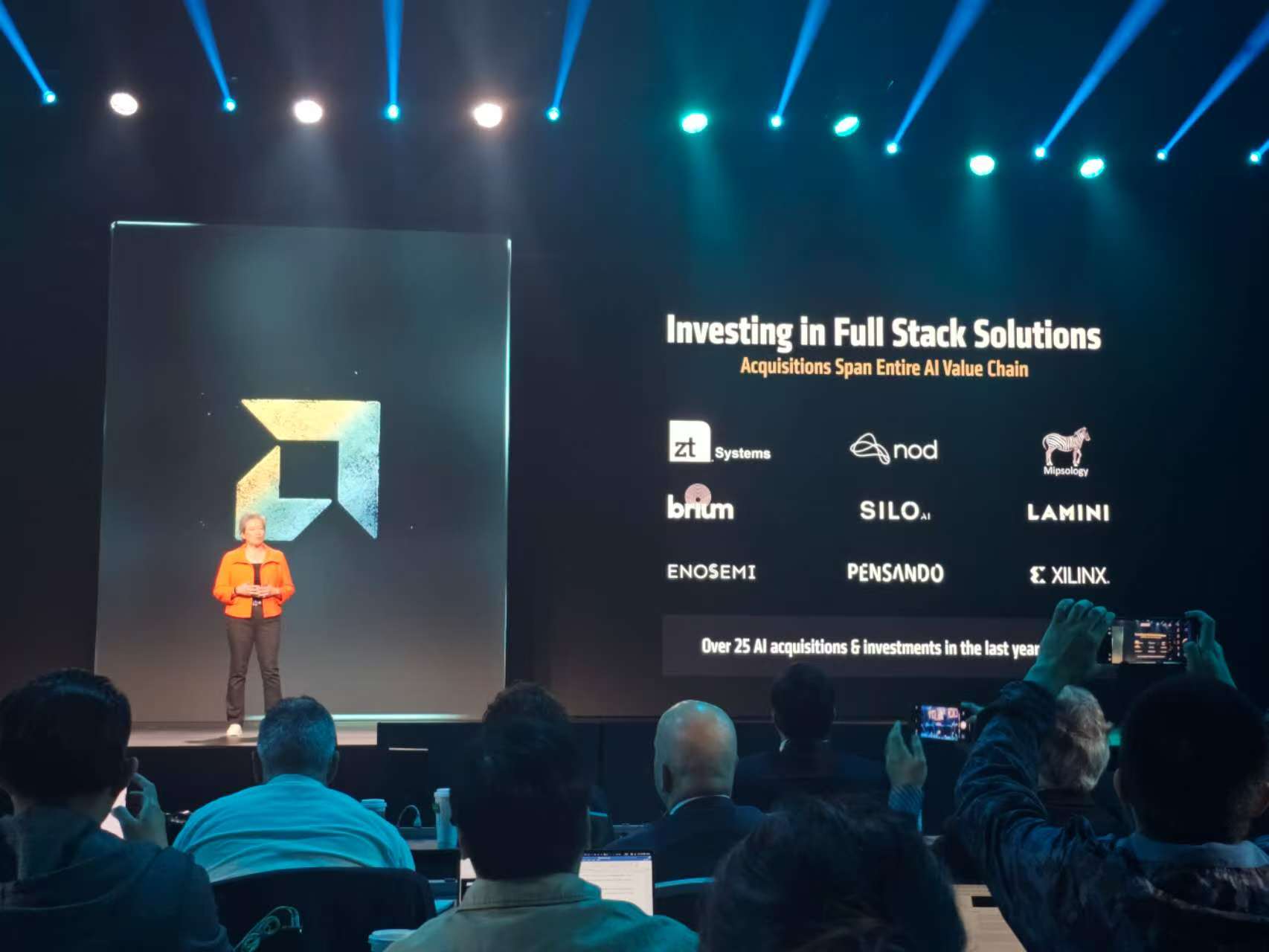

二是大力投入AI,过去几年AMD围绕AI进行了超过25笔投资。三是提供全栈的AI解决方案。

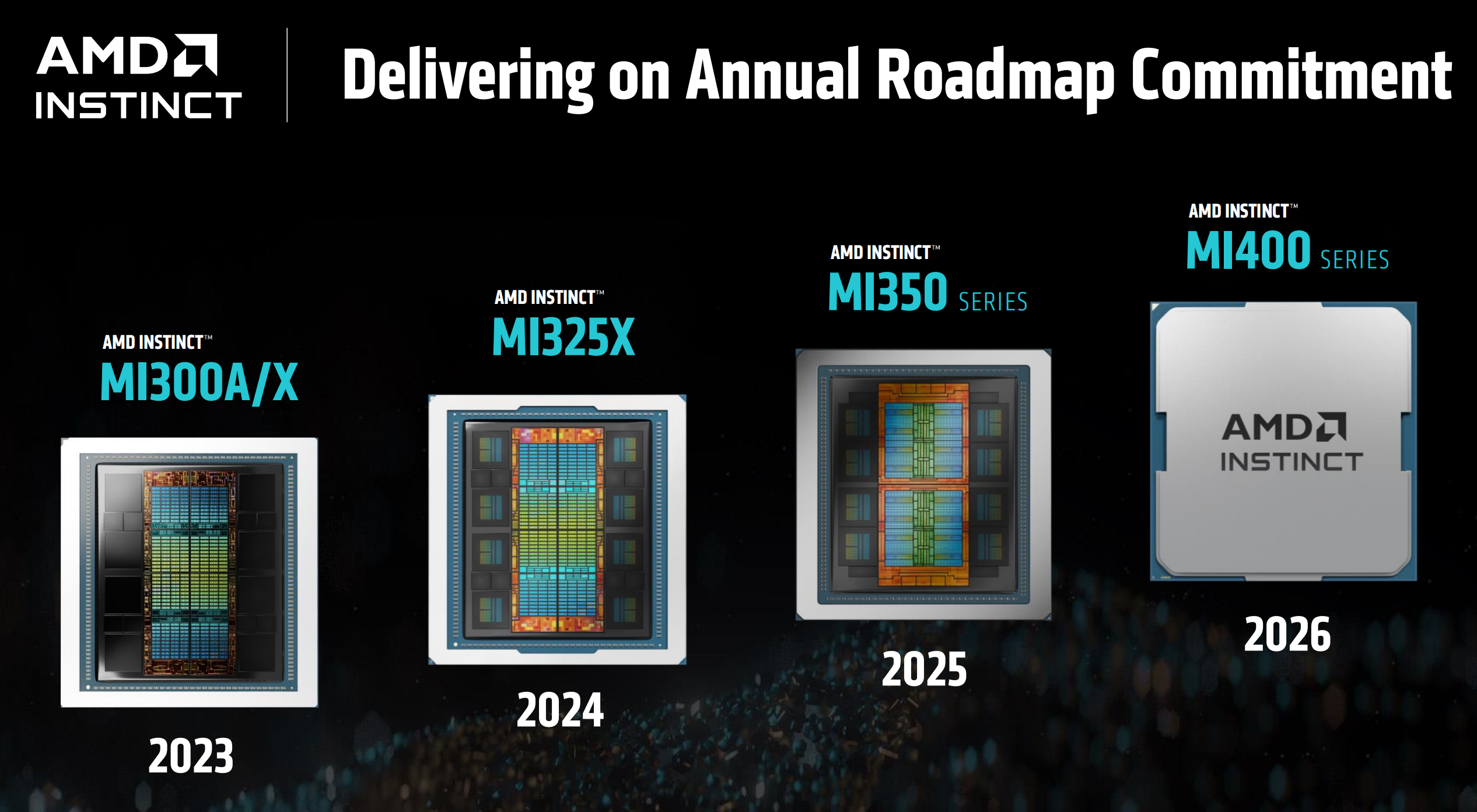

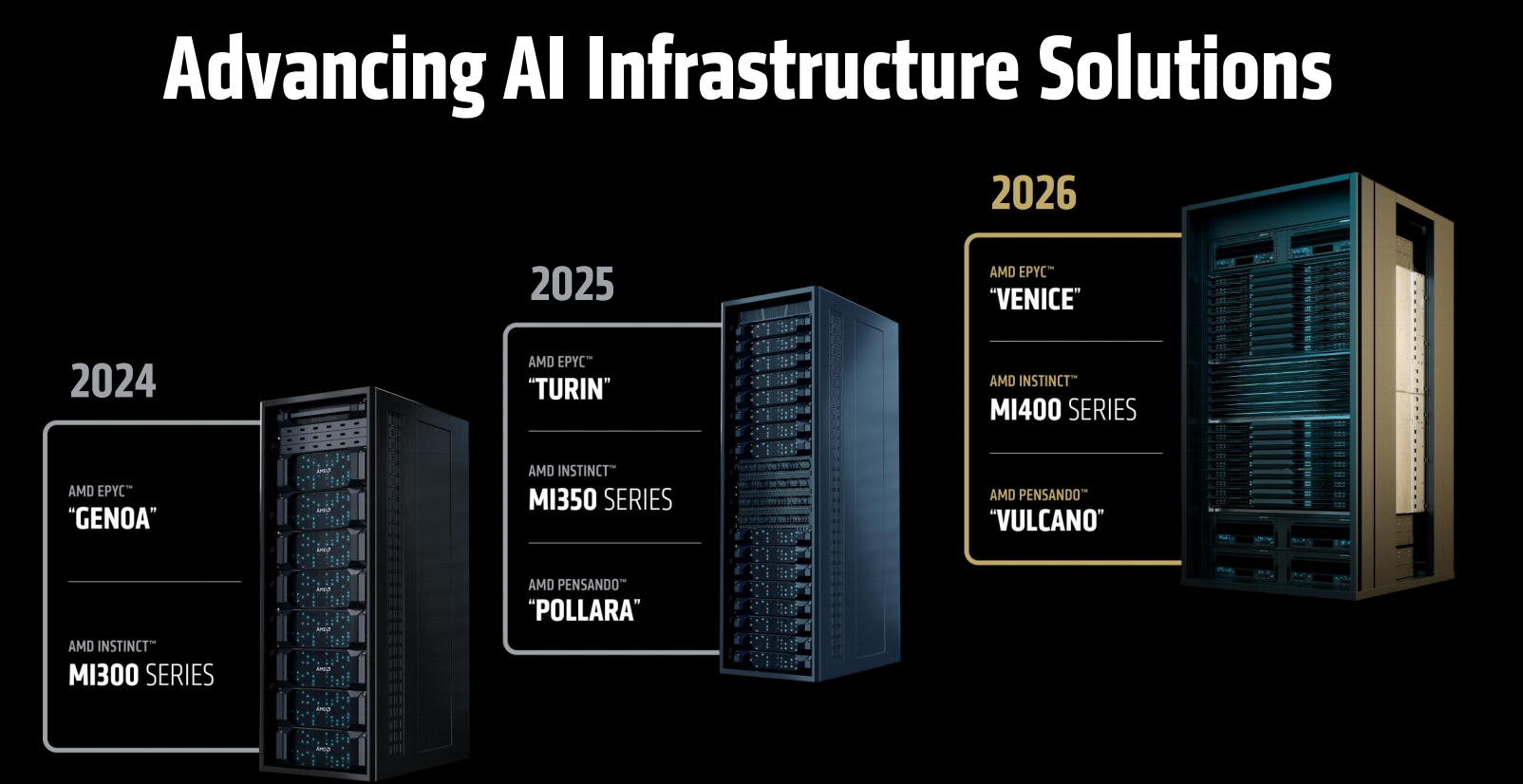

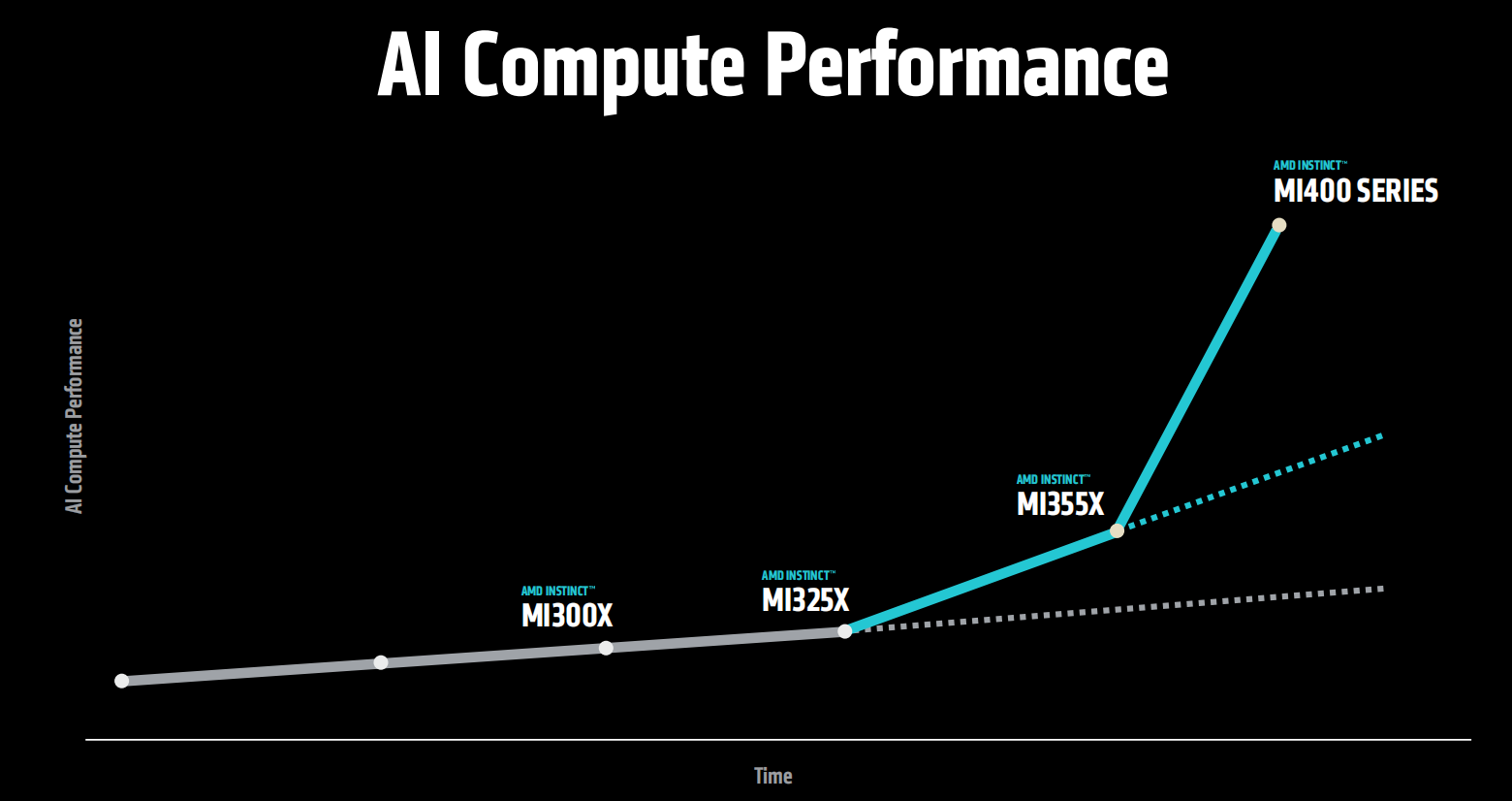

自2023年推出MI300系列以来,Instinct GPU系列保持每年已更新的节奏持续快速迭代,通过持续的工艺、架构等方面的创新,显著提升产品的性能和能效,并持续拓展市场规模。

当前,全球10家顶级AI公司中有7家在规模部署Instinct系列。而最新一期全球超级计算机Top500榜单中,排名前两位的超级计算机,均采用AMD的Instinct GPU和EPYC CPU解决方案。

目前,已经有超过35家厂商采用MI300系列平台。这表明AMD在高性能计算领域的行业领导力正在显著提升。

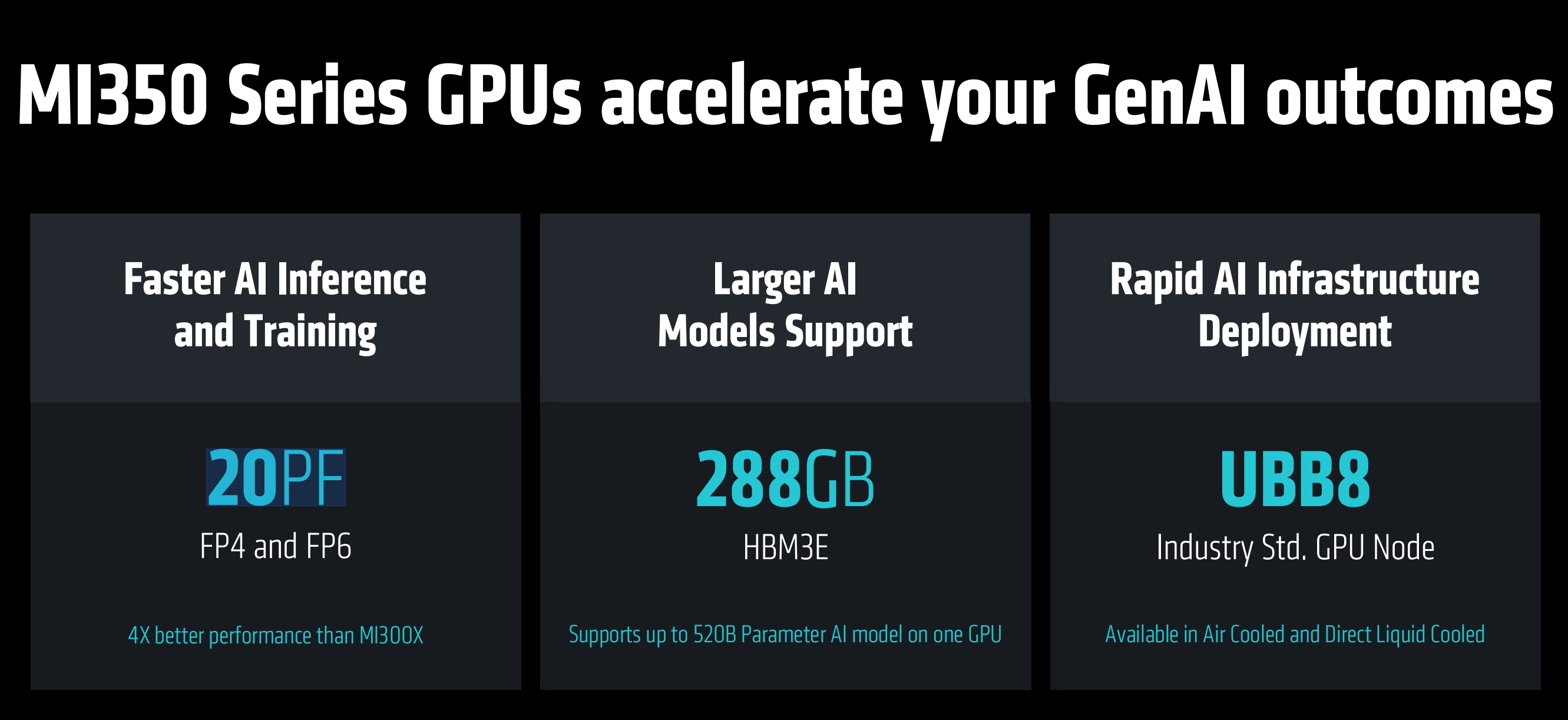

Instinct MI350系列:推理能力提升3倍 加冕AI新王

此次推出的MI350系列GPU包括MI350X GPU和MI355X GPU,采用CDNA4架构,3nm工艺制程,具有1850亿晶体管,支持FP4和FP6的全新生成式AI数据类型,采用业界领先的HBM3E存储方案。不同之处在于MI355X系统功率较高从而提供更高性能,主要针对液冷,MI350X提供风冷及液冷两种配置,从而支持广泛的数据中心部署。

MI350系列产品具有更加快速的AI训练和推理能力,4位和6位浮点精度下能够实现20PFLOPS(每秒千万亿)的算力。

MI350采用288GB的HBM3E,能够实现一颗GPU支持最高5200亿参数的AI大模型。

MI350系列采用符合行业标准的GPU计算节点UBB8的通用基板设计,便于在现有的数据中心进行快速的AI基础设施部署,提供风冷和直接液冷两个版本,适用于不同散热需求的数据中心或AI计算集群部署。

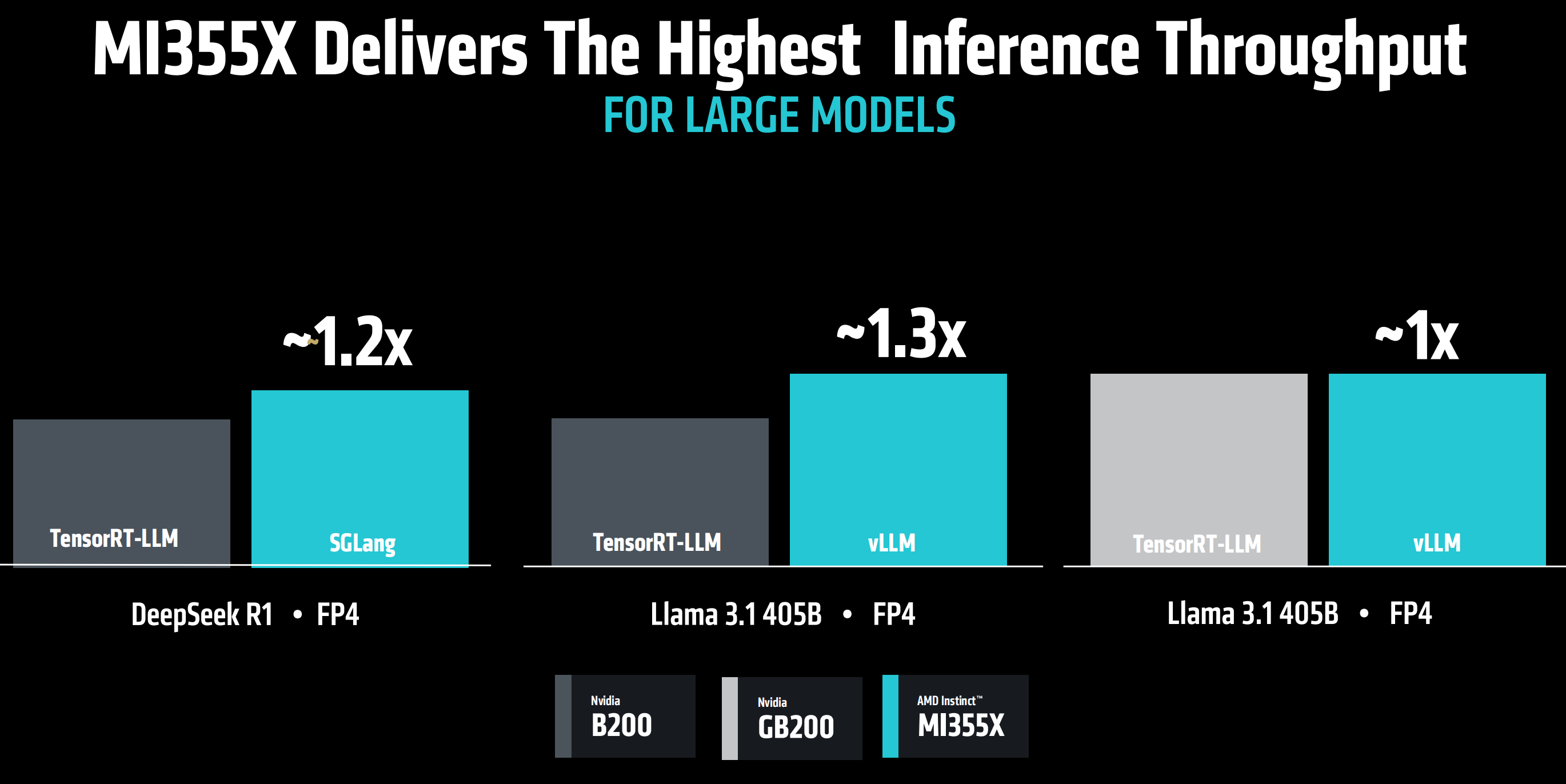

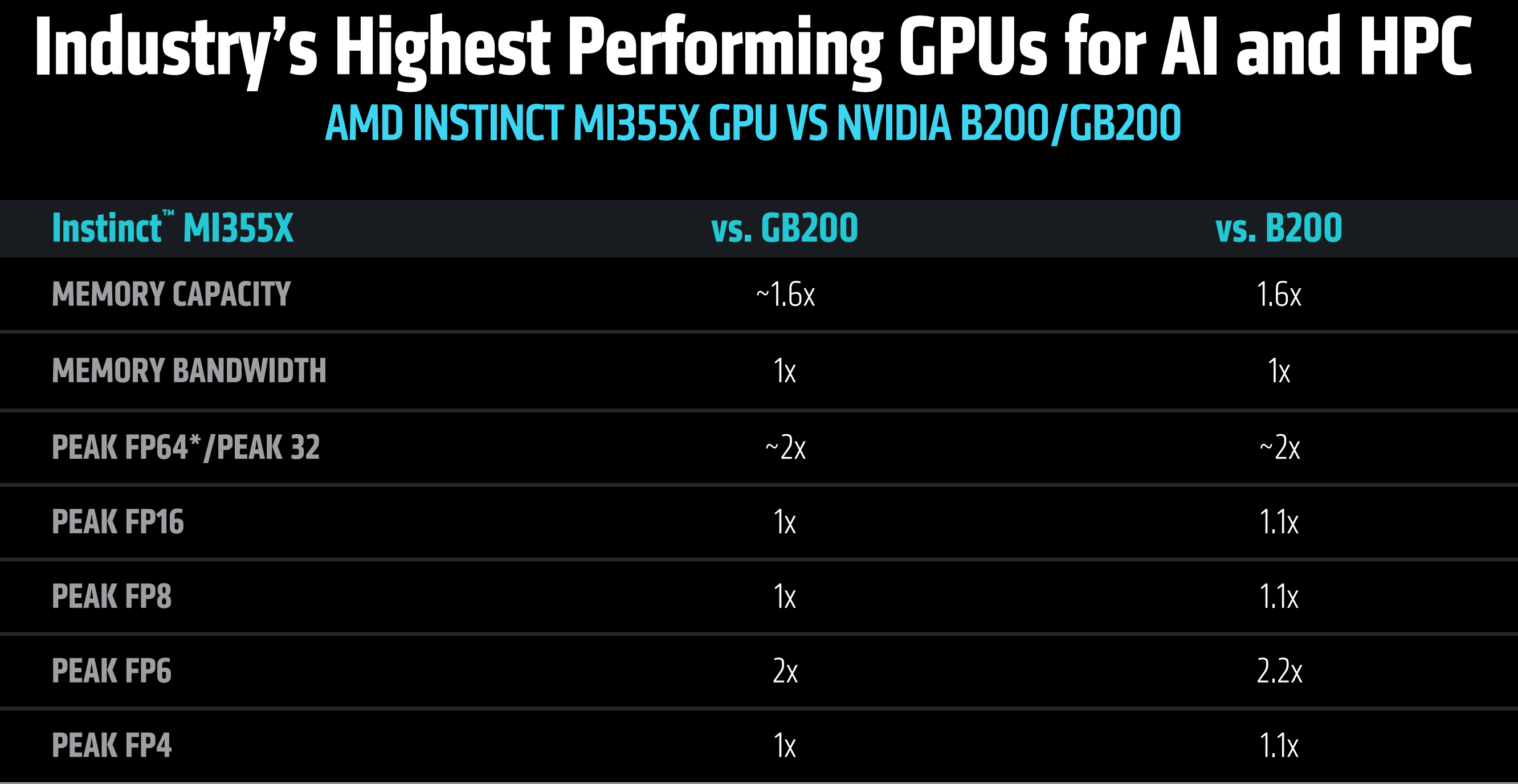

在同NVIDIA包括GB200以及B200在内的顶级GPU的对比中,MI355X成为面向AI和高性能计算领域的业界最高性能的GPU产品。

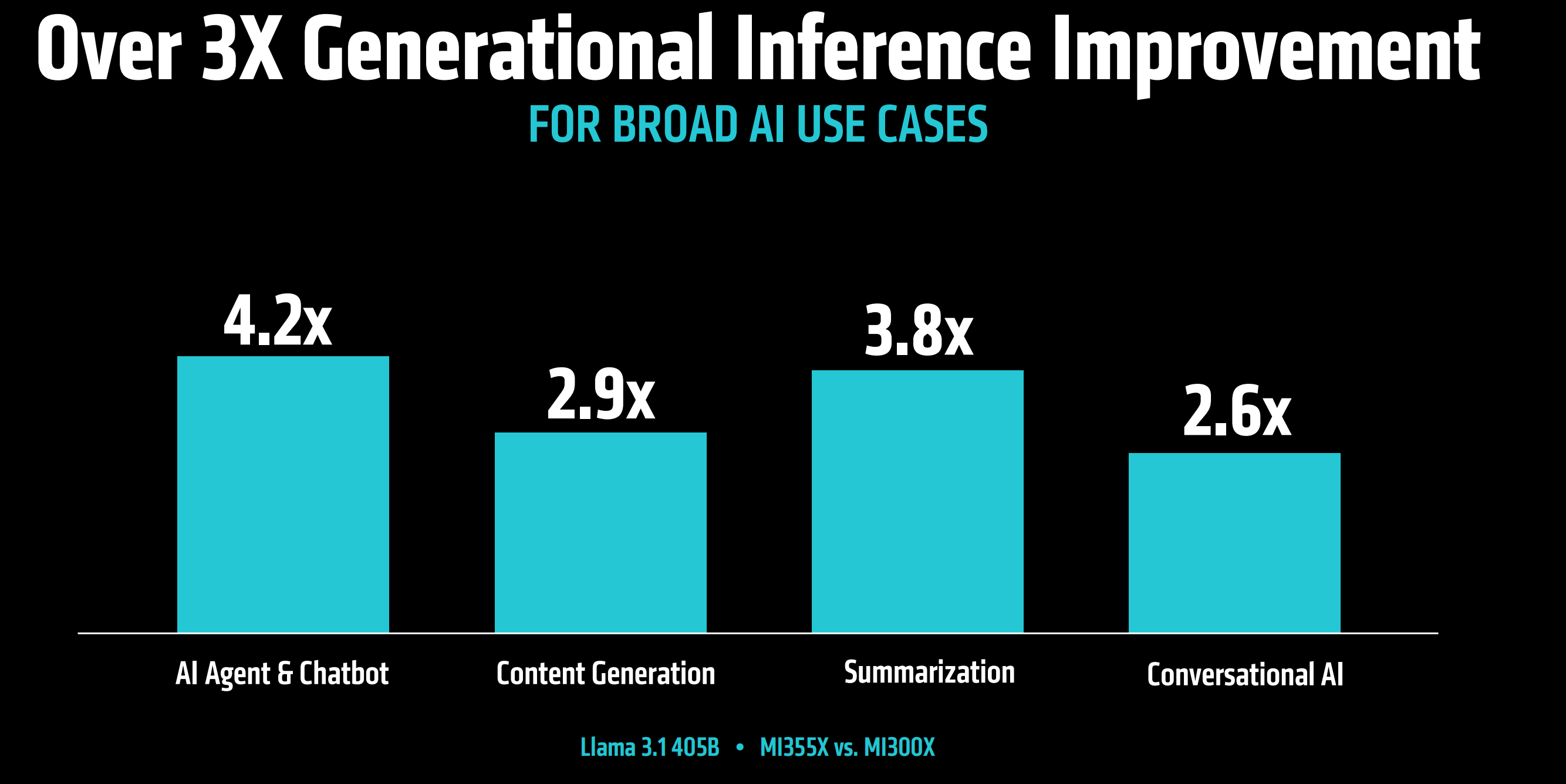

在如AI智能体,内容生成等推理应用性能表现方面,MI355X相比上一代MI300X产品,推理能力平均提升3倍。

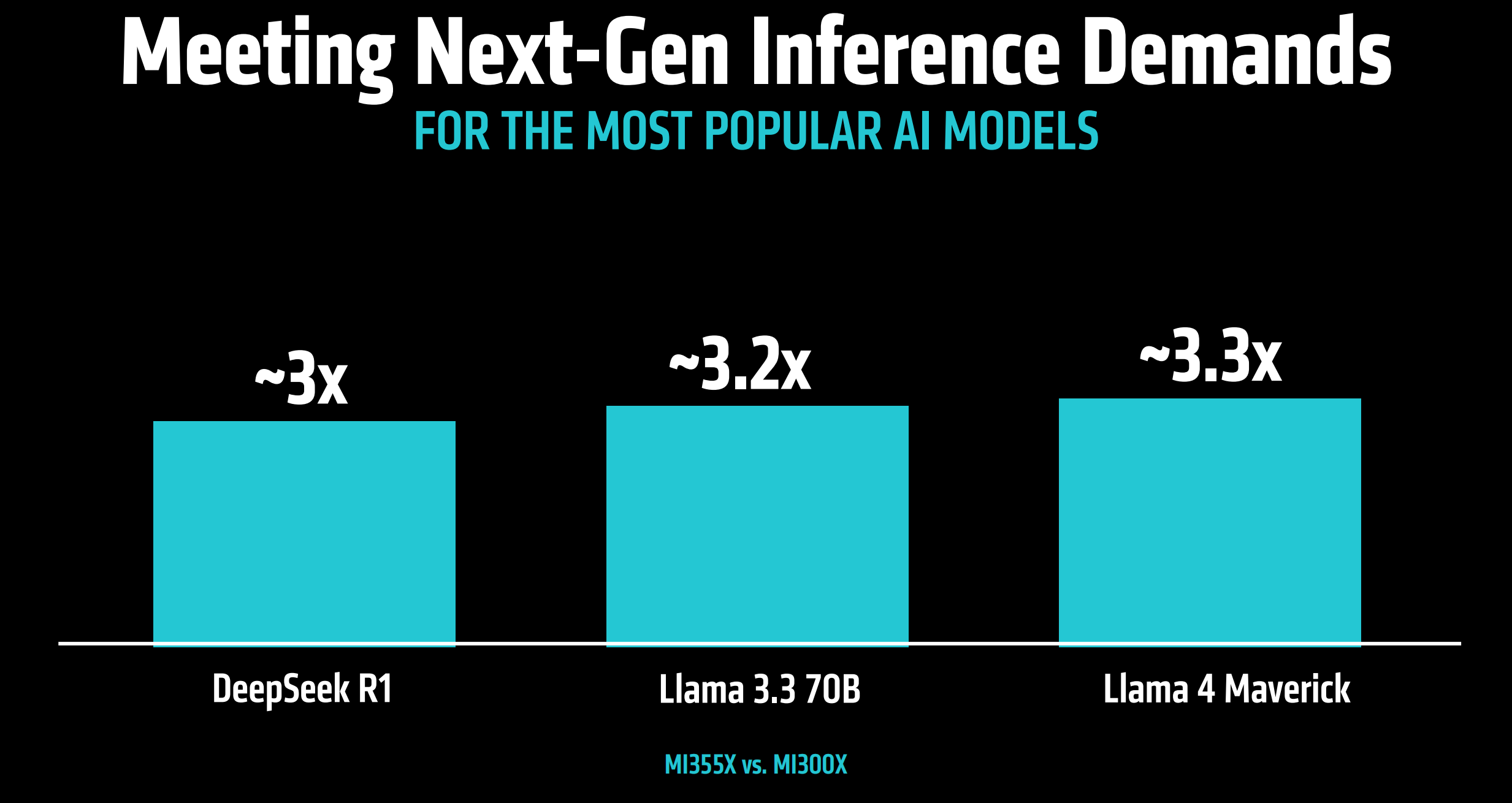

面向下一代推理需求,比如针对Deepseek R1、Llama 3.3 70B以及Llama 4 Maverick等当下主流AI模型,MI355X相比于MI300X,推理能力提升3倍以上。

同英伟达的B200、GB200竞品相比,MI355X对于主流大模型的推理能力也领先1倍以上。

同时,相比于B200,使用MI355X能够带来显著的性能成本优势,相同成本下,能够处理的Token数量提升40%。

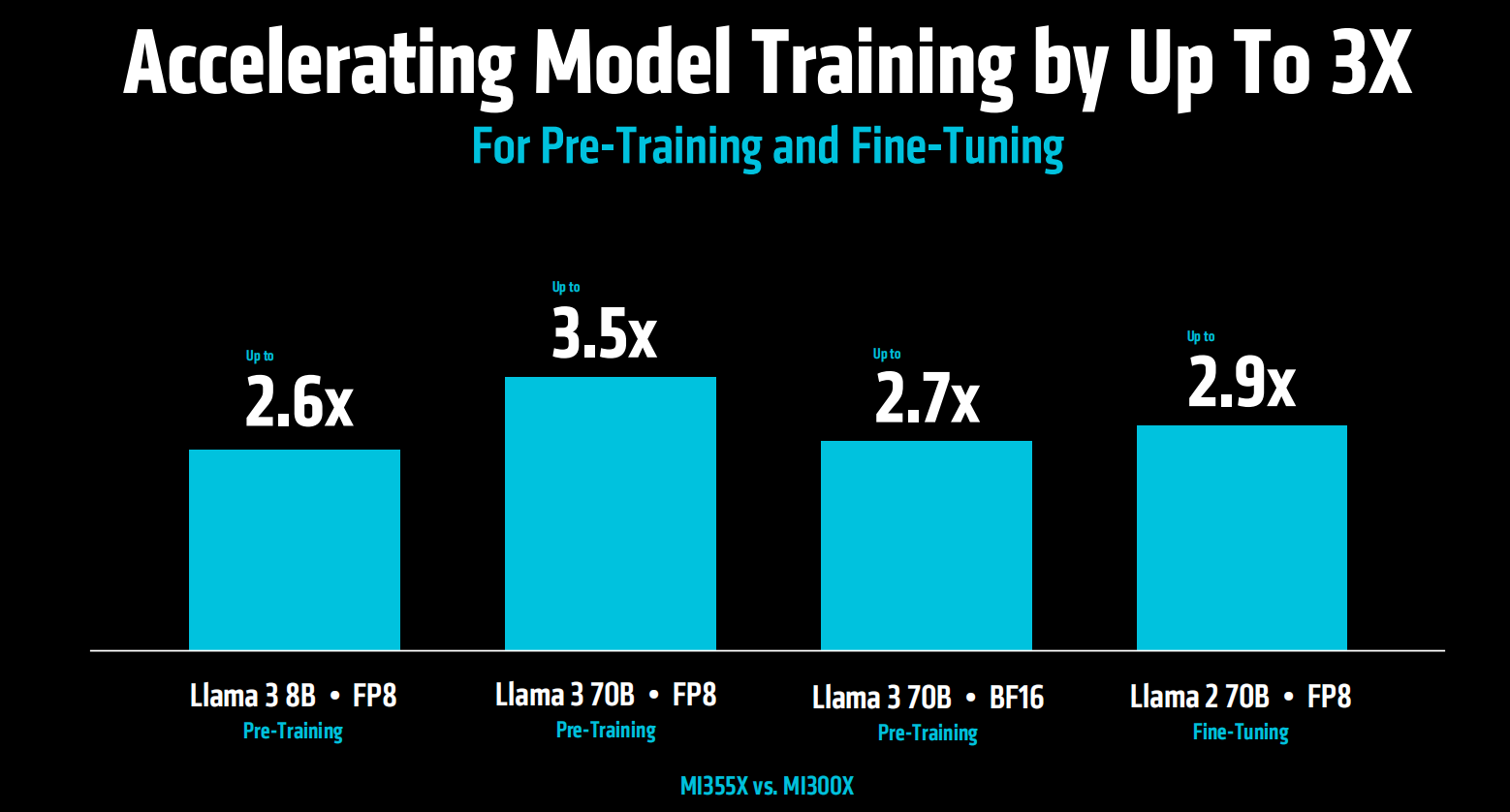

面向预训练和微调,MI355X对比MI300X能够实现模型训练的3倍加速。

相较于竞品GB200和B200,MI355X在训练性能方面也有1倍以上的提升。

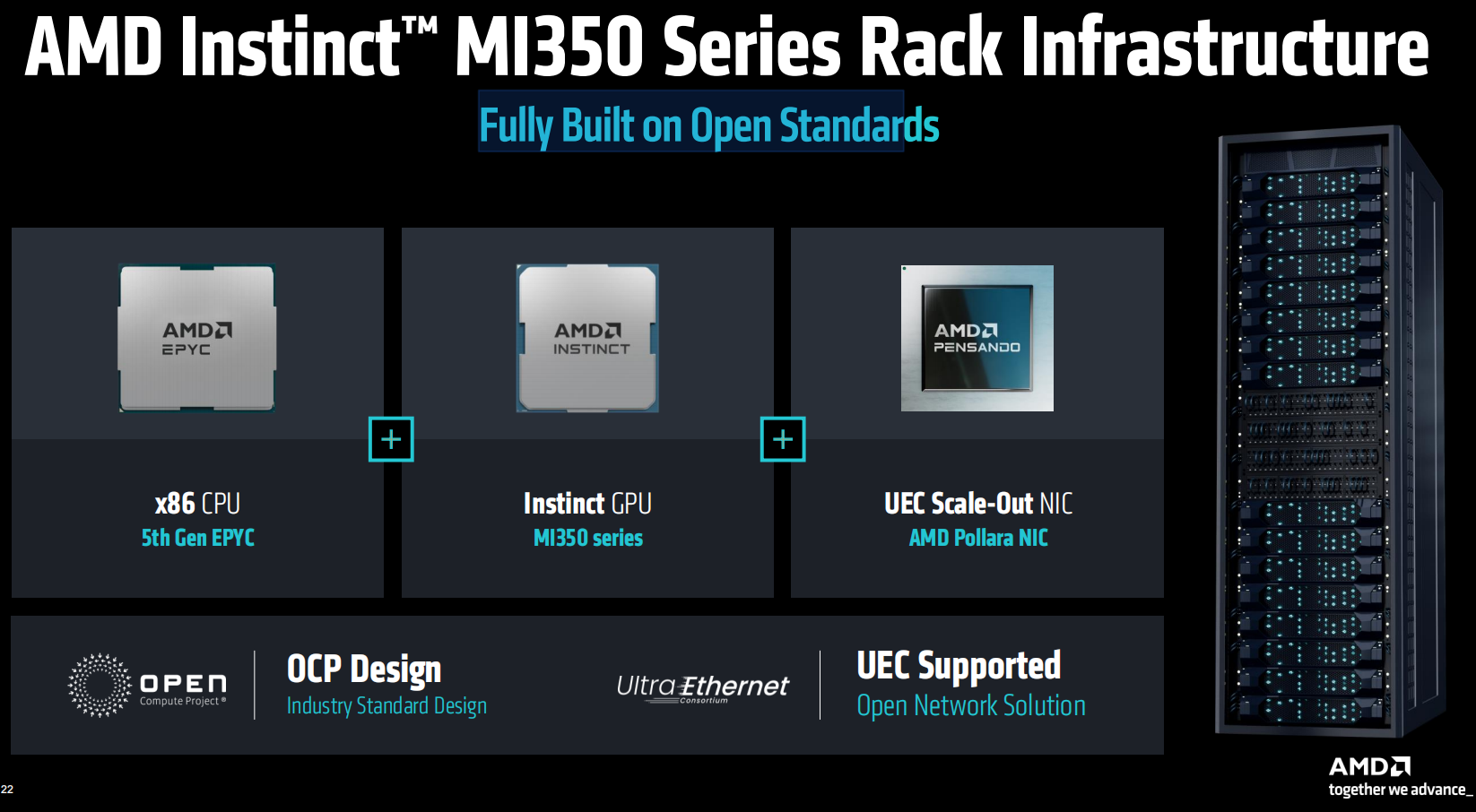

MI350系列的服务器机架解决方案在硬件和软件层面均遵循开放标准,包括第五代EPYC CPU以及AMD Pollara NIC。基于风冷的MI350机架解决方案,单机架可以支持最多64个GPU,从而支持更传统的数据中心部署。

此前,AMD提出2020-2025年,将用于AI训练和高性能计算的AMD处理器和加速器的能效提高30倍,Instinct MI350将这一能效提升至35倍,超额完成任务。

此外,AMD还提出了新的五年目标,即到2030年,将机架规模能效提升20倍,意味着五年后,一个通常需要275个机架来训练的典型AI模型,可以在不到一个机架中完成训练,同时电耗降低95%。

据介绍,目前MI350系列解决方案正在向客户出货,预计第一波服务器合作伙伴相关产品以及CSP厂商的相关用例将于今年Q3推出。

强化软件生态:ROCm7正式发布 支持UALInk1.0

在保持硬件领先性能的基础之上,近年来,AMD持续发力软件生态建设,软件生态也被视为AMD在AI领域实现真正破局的关键。

此次会上,AMD发布了最新的开发工具ROCm 7,旨在通过大幅提升性能、分布式推理、企业解决方案以及在Radeon和Windows上的更广泛支持,与开源社区携手共同驱动AI行业进一步发展。

与ROCm 6相比,ROCm 7的推理能力提升超过3.5倍,训练能力提升3倍。

同时,AMD为开发者提供了开发者云服务,它允许开发者即时、无硬件限制地访问最新发布的Instinct MI350系列GPU,配备预配置环境和免费试用额度,帮助开发者们实现无缝AI开发和部署。

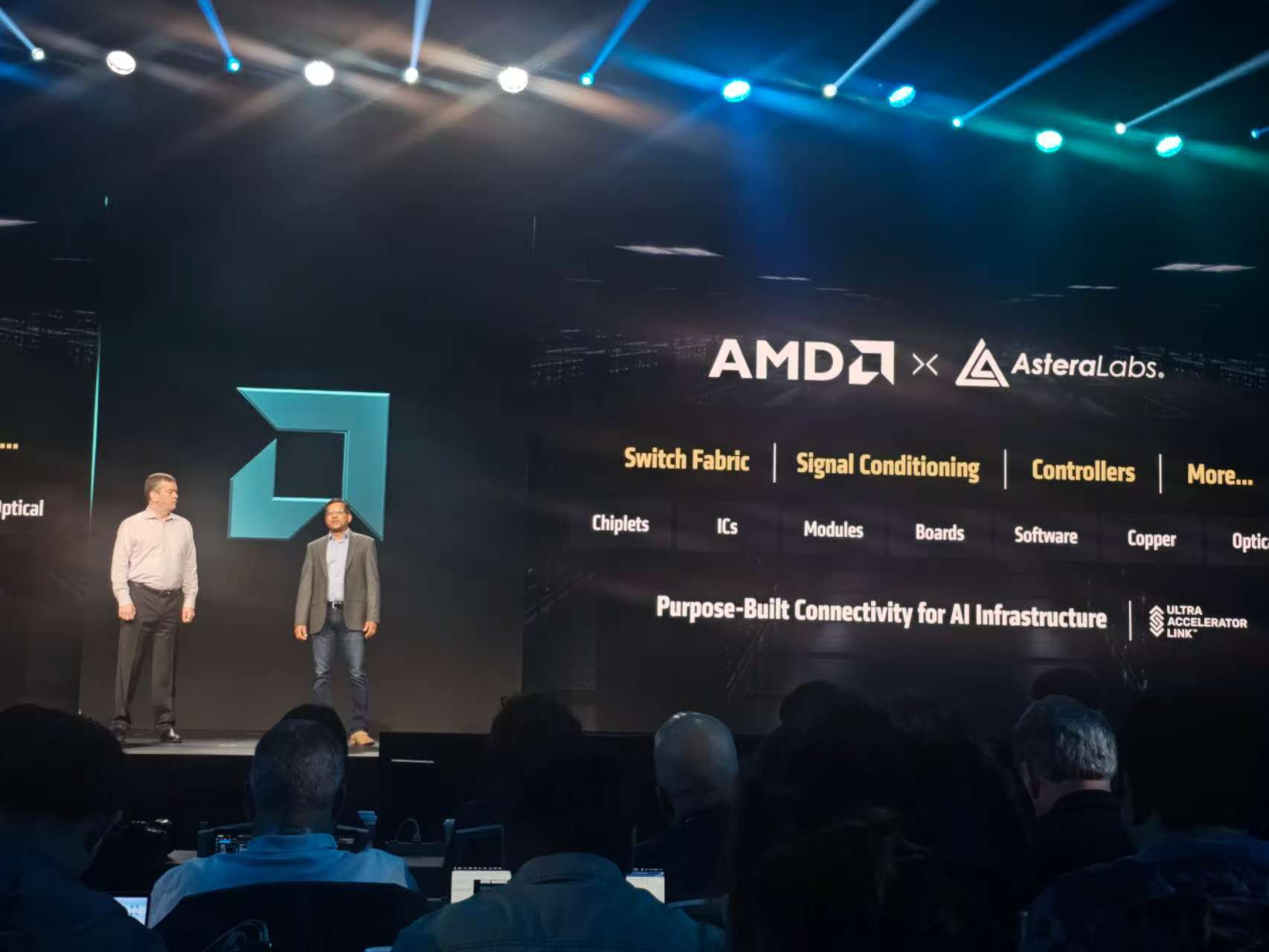

此外,今年4月,汇聚AMD、亚马逊AWS、谷歌、英特尔、Meta、微软等大量科技企业的UALink联盟正式发布了1.0版本的UALink 200G加速器高速互联规范,旨在挑战英伟达NVLink技术在GPU加速器大规模并行互联方面的领导地位。此次大会上,AMD宣布支持最新的UALInk1.0规范。

发布会上,苏姿丰博士特别强调,人工智能的未来不会由任何一家公司创造,也不会存在封闭的生态中,它将由开放合作塑造。

2026四大看点值得期待 MI400将迎史诗级飞跃

此次大会上,AMD还进行了对于未来即将推出的一系列创新产品的预告。

一是将于2026年发布的AI基础设施解决方案,集成了第六代 EPYC CPU VENICE,Instinct MI400系列GPU,以及Pensando VULCANO加速器。

二是20206年将会推出优化的AI机架解决方案“Helios”,采用统一架构,专为前沿的模型训练设计,提供领先的计算密度,内存,带宽和可扩展规模。相较于英伟达下一代集成AI GPU Vera和CPU Rubin的Oberon机架架构,Helios在扩展带宽、存储带宽等性能指标方面实现1-1.5倍的提升。

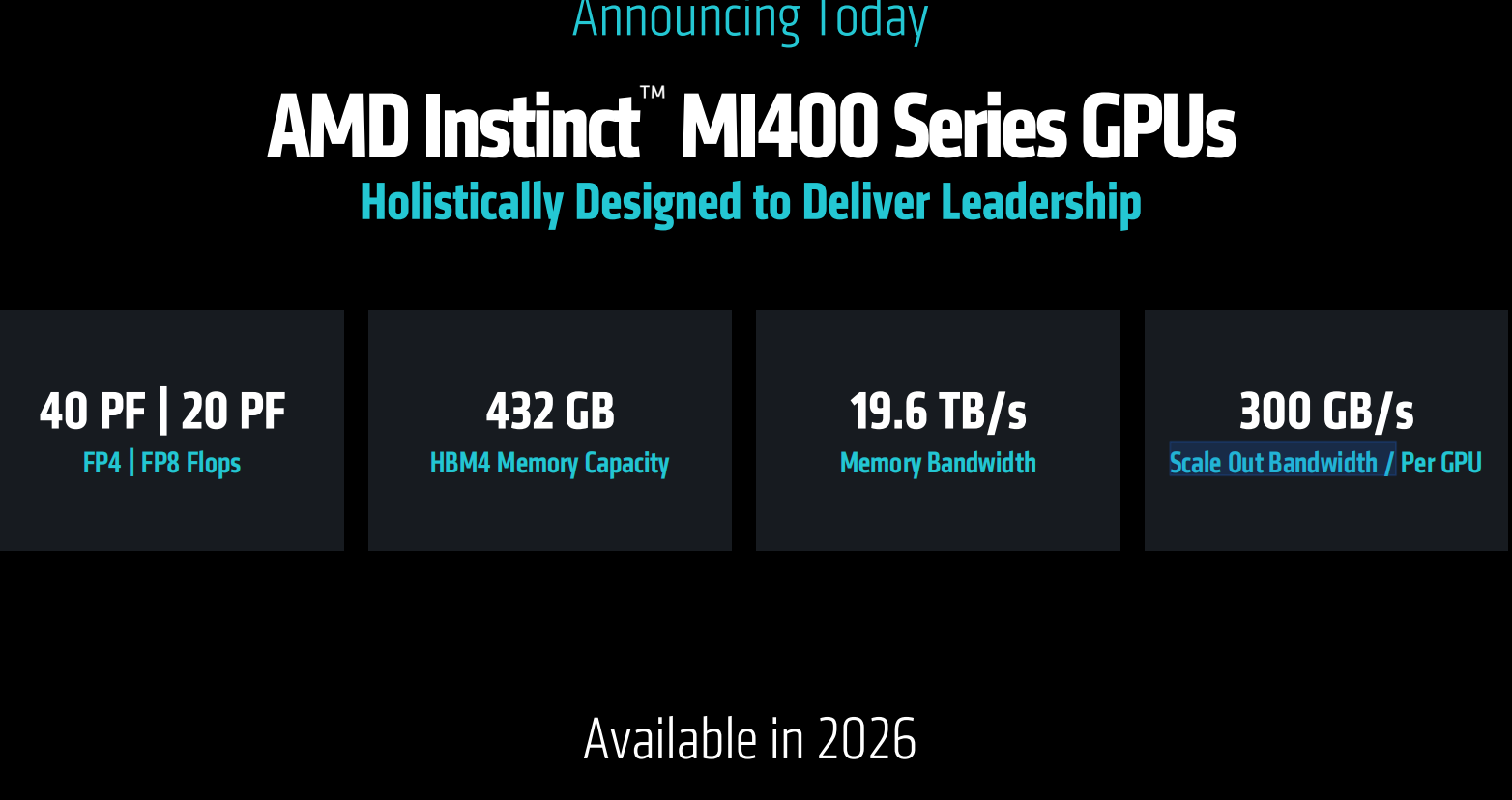

三是宣布2026年推出AI计算性能大跃进的Instinct MI400系列GPU,包括FP4/FP8精度下40PF/20PF的算力,432GB的HBM4,19.6TB/内存带宽,单GPU横向拓展带宽300GB/s。

四是宣布2027年采用新一代EPYC VERANO CPU、Instinct MI500系列GPU、PENSANDO VULCANO加速器的未来AI机柜。同样保持一年一更新的节奏。

十大伙伴站台奥特曼压轴 AI行业影响力彰显

此次发布会上,来自openAI、Meta、xAI、HUMAIN、微软、红帽等众多重量级合作伙伴登台分享了他们如何使用AMD AI解决方案来训练当前领先的AI模型,为大规模推理提供动力,并加速AI探索和开发。

据笔者观察,这也是近年来“AI Advancing” 大会中客户站台数量最多的一次。反映出AMD的行业影响力和号召力的同时,也表明其领先的AI解决方案正在被行业广泛认可和接受。

Meta详细介绍了Instinct MI300X在LLama 3和Llama 4推理中的广泛应用。介绍了MI350在计算能力、性能/TCO方面的表现。Meta表示,未来将继续与AMD在AI路线图上紧密合作,包括将在未来部署Instinct MI400。

甲骨文云基础设施是首批采用搭载Instinct 355X GPU开放式机柜的厂商,宣布将采用最新AMD Instinct处理器加速的zettascale AI集群,该集群最多配置131072个MI355X GPU,帮助客户大规模构建、训练和推理AI。

日前,AMD与沙特人工智能公司Humain达成100亿美元的重磅战略合作。HUMAIN相关代表在此次会议上介绍了合作的相关内容,包括利用AMD提供的全方位计算平台,构建开放、可扩展、有弹性和成本效益的AI基础设施等。

微软宣布Instinct MI300X已在Azure上为专有和开源模型提供支持。

Cohere分享了其高性能、可扩展的Command模型部署在Instinct MI300X上的实践,以高吞吐量、效率和数据隐私为企业级LLM推理提供动力。

红帽介绍了其与AMD扩大合作如何实现AI环境,通过红帽OpenShift AI上的Instinct GPU,在混合云环境中提供强大、高效的AI处理。

Astera Labs强调了开放的UALink生态系统如何加速创新,并为客户提供更大的价值,同时分享了提供全面的UALink产品组合以支持下一代AI基础设施的计划。

Marvell分享了采用UALink规范的交换机产品的技术路线图,作为UALink联盟的成员,双方将共同开发开放式互连规范,为AI 基础设施带来极致灵活性。

OpenAI的CEO山姆奥特曼同苏姿丰博士讨论了整体优化的硬件、软件和算法的重要性,以及 OpenAI与AMD在AI 基础设施方面的密切合作,包括在MI300X 上生产的Azure上的研究和GPT模型,以及在 MI400 系列平台上的深度合作。

“当我第一次听到芯片的一些规格时,我心想这不可能,听起来太疯狂了。这将是一件了不起的事情。” 奥特曼表示。

6.突破AI与HPC散热瓶颈:贺利氏下一代TIM1导热膏重磅发布

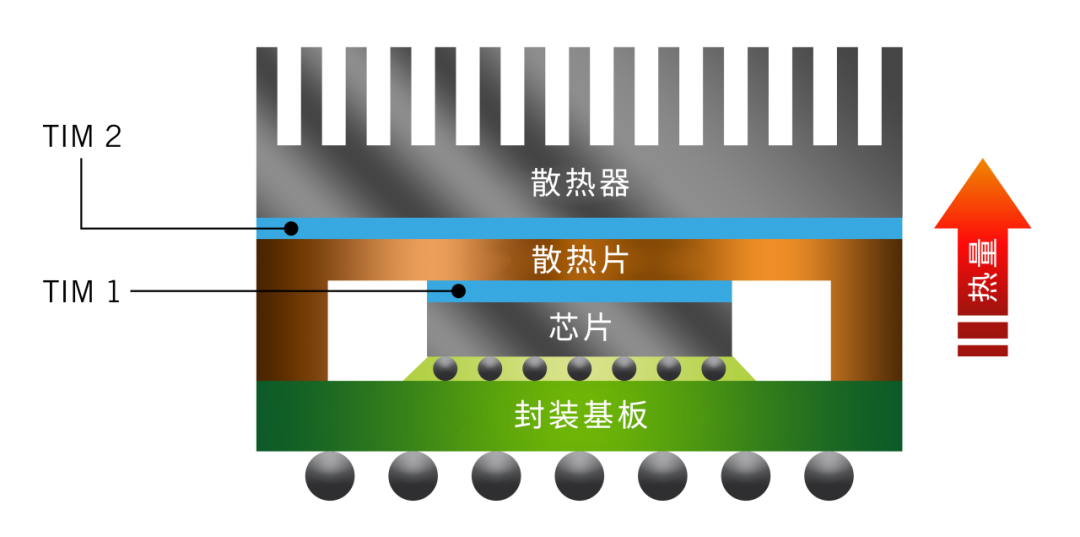

在设备持续高集成,高算力,高功耗,性能不断突破的今天,散热管理面临着前所未有的挑战,特别是在高性能计算(HPC)和人工智能(AI)等前沿领域。随着热负荷的持续攀升和封装要求的日益严苛,高性能导热界面材料(TIM)已从可选配件转变为不可或缺的关键组件。

为此,贺利氏电子推出创新研发的TIM1导热膏,凭借卓越的导热性能、简化的加工工艺和持久的可靠表现,为最严苛的应用环境提供专业级解决方案。

为什么TIM1如此重要

导热界面材料(TIM)被应用于发热组件(如硅芯片)和散热器或散热片之间,以确保高效的热传递。TIM1直接用于芯片和盖板之间,其作用包括:

填充由表面粗糙度引起的微小气隙

增强散热

防止组件过热

提高设备的长期可靠性

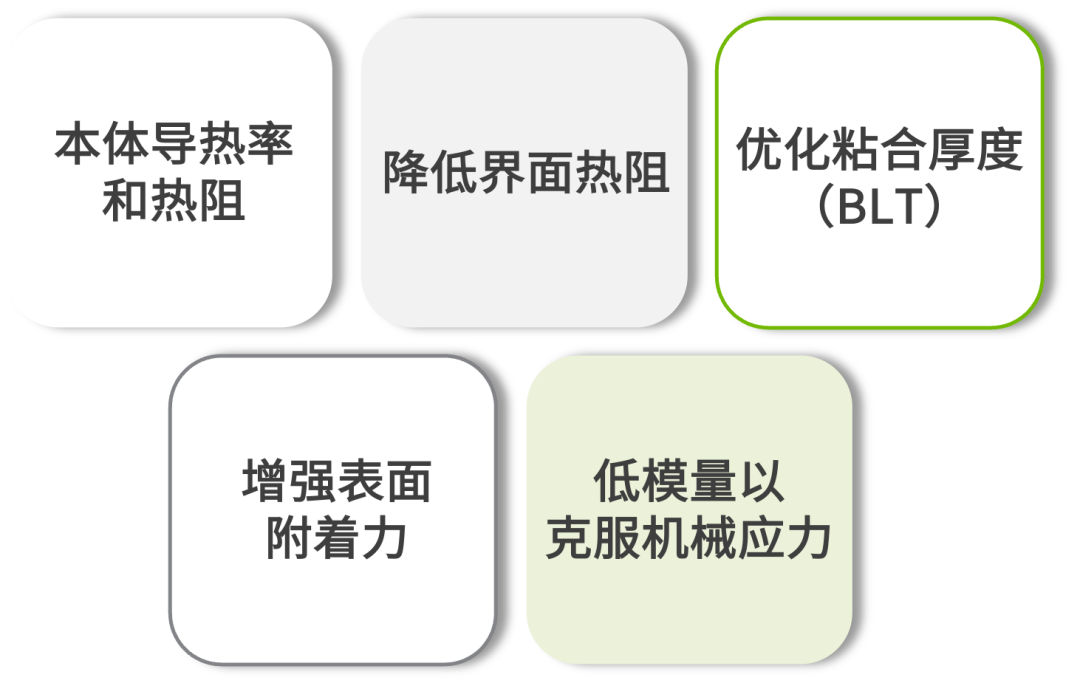

然而,选择理想的TIM1并不总是那么简单。工程师们必须应对各种挑战和考虑因素:

关键选择标准:

常见挑战:

硅片和基板的翘曲和热应力会影响TIM覆盖率的一致性

气孔生长会增加热阻

物理性能(如延伸率、附着力和模量)之间的权衡

性能卓越且工艺友好的TIM1导热膏

为了直接应对这些挑战,贺利氏电子开发了一款基于复合聚合物-银技术的突破性TIM1导热膏,在不牺牲加工简便性的前提下,提供了行业领先的散热性能。

主要特点与优势:

卓越的导热性

高于30 W/m·K,满足AI和HPC处理器的严苛散热需求

无需BSM

强大的附着力消除了背面金属化(BSM)的需求,简化了工艺流程

可释放应力的聚合物基体

即使在高温下,也能最大限度地减少接触热阻并吸收机械应力

制造简化

更少的加工步骤和易于应用,可适配客户各种集成工艺

无论您开发的是下一代数据中心、AI加速器还是高频计算平台,我们的TIM1导热膏都能确保设备在极致性能需求下保持高效散热、稳定运行与长期可靠。(来源: 贺利氏电子)