据新数据显示,英伟达最新芯片在大型人工智能(AI)系统训练方面取得进展,训练大型语言模型所需的芯片数量大幅下降。

MLCommons是一家发布AI系统基准性能结果的非营利组织,它发布了英伟达和AMD等公司芯片的最新数据,这些芯片用于训练。在训练过程中,AI系统需要输入大量数据进行学习。尽管股市的大部分注意力已经转移到更大的AI推理市场(即AI系统处理用户的问题),但训练系统所需的芯片数量仍然是一个关键的竞争因素。中国的DeepSeek声称将使用比美国竞争对手少得多的芯片来打造一款具有竞争力的聊天机器人。

这是MLCommons首次发布的关于芯片在训练Llama 3.1 405B等AI系统方面表现的测试结果。Llama 3.1 405B是由Meta Platforms发布的开源AI模型,其拥有足够多的“参数”,足以展现芯片在处理一些全球最复杂的训练任务(可能涉及数万亿个参数)时的表现。

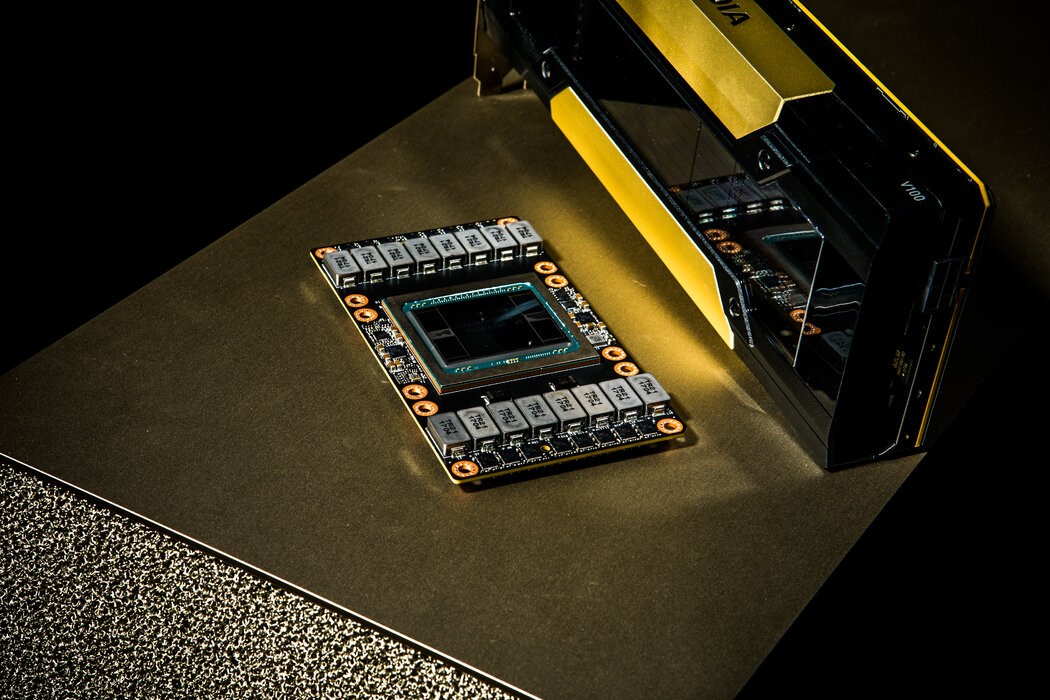

英伟达及其合作伙伴是唯一提交该大型模型训练数据的参赛者。数据显示,英伟达的新款Blackwell芯片的单芯片速度是上一代Hopper芯片的两倍多。

英伟达新款芯片最快的测试结果是,2496块Blackwell芯片在27分钟内完成训练测试。数据显示,许多英伟达上一代芯片的测试时间是Blackwell芯片的三倍多,才能达到更快的速度。

CoreWeave首席产品官Chetan Kapoor表示,AI行业目前有一种趋势,即将更小的芯片组串联成子系统,用于单独的AI训练任务,而不是创建10万块或更多芯片的同质组。该公司与英伟达合作开发了部分成果。

Chetan Kapoor表示:“使用这样的方法,他们能够继续加速或缩短训练这些拥有数万亿参数的模型所需的时间。”