近日,中山大学电子与信息工程学院(微电子学院)谢曦教授团队设计研发了一种基于深度学习架构增强的抗噪声学传感系统,实现了在极端噪声环境中的复杂人机协同交互,相关研究成果发表在Nature Communications,论文题目为:“Deep learning-enhanced anti-noise triboelectric acoustic sensor for human machine collaboration in noisy environments”,博士生姚传捷为第一作者,谢曦教授为通讯作者。

随着人工智能和物联网技术的快速发展和融合,人机协同作业在健康监测、灾难后救援、智能控制等多个领域展现出巨大潜力。人机交互的方式也从最初的键盘、遥控器等外部设备操控,发展为更加直接和高效的肢体动作、电生理学和语音信号等方式实现交互。语音识别技术与智能设备的不断发展进步,促使基于传统语音信号的人机交互方式得到了广泛的应用,并且实现了大范围的商业化。然而,现阶段常规的声学传感器主要针对常见的生活场景进行设计和生产,当面对一些复杂的极端噪声环境时(例如,嘈杂的人群、火灾和暴雨等环境),往往会受到严重的干扰和影响,难以获得完整信息的语音信号实现准确的人机语音交互。这种特征缺失或波形畸变的声学模态信号,对传统的语音处理技术与人机语音交互系统提出了相当大的挑战,严重限制了其在复杂场景中的应用。

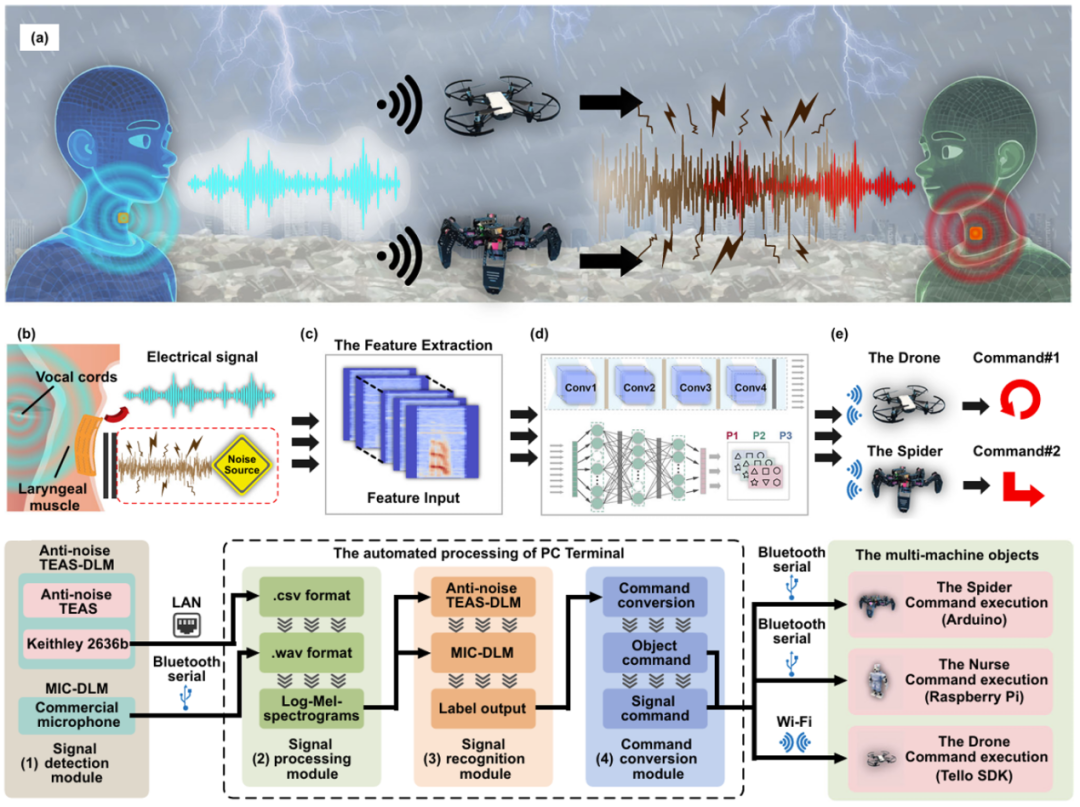

深度学习架构增强的抗噪声学传感系统示意图

针对现阶段常规人机语音交互在极端噪声环境中的不足,谢曦教授团队设计开发了一种基于深度学习架构增强的柔性抗噪声学传感集成系统,以实现在极端嘈杂环境中的复杂人机协同交互。柔性抗噪声学传感器(Anti-noise TEAS)通过结构优化与缓冲设计,能够以接触式传感的方式,从喉部混合模态振动中捕获人声基频信号,同时有效抑制极端环境噪声的干扰,显著提升了在复杂噪声场景下的语音信号识别能力。在此基础上,团队进一步将Anti-noise TEAS与基于卷积神经网络的深度学习模型(CNN-based DLM)相结合,构建了集成化的Anti-noise TEAS-DLM人机协同系统。该系统不仅实现了对语音信号的高保真解释,还能在极端噪声干扰的虚拟场景和真实场景中,以近乎完美的噪声免疫性能,精准地识别和传输各种语音指令(识别准确率大于99%)。相较于传统的人机语音交互系统,Anti-noise TEAS-DLM具有更为优异的人机协同效率,可以在不同的场地、不同的噪声环境中,高效地引导机器群体系统执行复杂的灾难后救援任务(成功率达100%)。

谢曦教授团队开发的基于深度学习架构增强的柔性抗噪声学传感集成系统,为复杂环境下的高效人机协作提供了一种切实可行的方案。该系统凭借其卓越的抗噪声性能、高灵敏度和稳定性,以及深度学习智能化架构的强大语音识别能力,有望在灾难救援、野外探索、工业生产等多个领域得到广泛应用,推动人机交互技术向更加智能化、高效化的方向发展。